|

TwojePC.pl © 2001 - 2025

|

|

S P R Z Ę T |

|

| |

|

GeForce 4 Ti4600 w wydaniu Gainwarda i Prolinka GeForce 4 Ti4600 w wydaniu Gainwarda i Prolinka

Autor: Kris

Data: 03/04/02

|

6-tego lutego nVidia oficjalnie przedstawiła światu swoje nowe układy graficzne NV25 i NV17, które otrzymały nazwy handlowe GeForce4 Ti oraz odpowiednio GeForce4 MX. Pierwsze wrażenia z testów słabszego układu GF4 MX przedstawiliśmy już wcześniej (tutaj i tutaj). Teraz przyszła pora na przybliżenie możliwości flagowego układu nVidia nowej generacji. W niecały miesiąc od prezentacji na rynek trafiły dwa modele kart wyposażonych w układy GF4 Ti4600 i GF4 Ti4400. W bliżej nieokreślonej przyszłości (nieoficjalnie: miesiąc) powinien do nich dołączyć również bardziej budżetowy model GF4 Ti4200, którego wejście na rynek zostało na razie wstrzymane, aby pozwolić na łagodne przejście w stan spoczynku nieźle sprzedających się kart GF3Ti. Dzięki uprzejmości firmy Action2 oraz firmy Multimedia Vision mam przyjemność a może nawet zaszczyt przedstawić Wam karty Prolink PixelView GeForce4 Ti 4600 oraz Gainward GeForce4 PowerPack!!! Ultra/750 XP "Golden Sample". 6-tego lutego nVidia oficjalnie przedstawiła światu swoje nowe układy graficzne NV25 i NV17, które otrzymały nazwy handlowe GeForce4 Ti oraz odpowiednio GeForce4 MX. Pierwsze wrażenia z testów słabszego układu GF4 MX przedstawiliśmy już wcześniej (tutaj i tutaj). Teraz przyszła pora na przybliżenie możliwości flagowego układu nVidia nowej generacji. W niecały miesiąc od prezentacji na rynek trafiły dwa modele kart wyposażonych w układy GF4 Ti4600 i GF4 Ti4400. W bliżej nieokreślonej przyszłości (nieoficjalnie: miesiąc) powinien do nich dołączyć również bardziej budżetowy model GF4 Ti4200, którego wejście na rynek zostało na razie wstrzymane, aby pozwolić na łagodne przejście w stan spoczynku nieźle sprzedających się kart GF3Ti. Dzięki uprzejmości firmy Action2 oraz firmy Multimedia Vision mam przyjemność a może nawet zaszczyt przedstawić Wam karty Prolink PixelView GeForce4 Ti 4600 oraz Gainward GeForce4 PowerPack!!! Ultra/750 XP "Golden Sample". |

Wstęp.

Pomimo tego, że zdecydowanej większości czytelników tego tekstu po prostu nie stać na zakup takich monstrum (cena >2000 zł) to jednak właśnie te najmocniejsze produkty, ta demonstracja siły producenta wzbudzają największe zainteresowanie i emocje. Umiejętna gra specjalistów od marketingu już dawno wywołała w nas podświadome skojarzenia sportowe tak bliskie naszej naturze. Niektórzy dali się złapać w tą sieć na tyle solidnie, że powoli zapominają o tym, do czego tak naprawdę powinna służyć karta graficzna i czego powinniśmy się spodziewać w zamian za pokaźną kwotę pieniędzy, którą za nią wydaliśmy. Jako, że od pewnego czasu można odnieść wrażenie, że rozwój silników gier 3D nie nadąża za eksplozją wydajności i możliwości nowych układów palącą potrzebą producentów stało się wypromowanie takich zachowań klientów, które pozwalałyby na sprzedaż nowych technologii nawet, jeśli realny zysk eksploatacyjny nie pokrywałby kosztów związanych z ich zakupem. Tak oto narodził się Benchmark. Chcecie igrzysk? No to macie. I poszliśmy jak barany na rzeź. Już nie jest w dobrym tonie zauważać, że w zasadzie wrażenia z wykorzystania kart w zastosowaniu, do którego były one przeznaczone są często zbliżone pomimo przepaści cenowej. Benchmark zaczął kreować potrzeby użytkownika. Nareszcie producent może zaszaleć z ceną. Wystarczy zrobić mistrza pomiaru, aby powstał fanklub. Mamy też w końcu proste i dobrze osadzone w świadomości odniesienie finansowe. Masz kasę - masz mistrza - jesteś lepszy. Mistrza należy oczywiście karmić Benchmarkiem bo nieco blednie w realnym zastosowaniu i tracimy poczucie wyższości a to jest już wbrew naszej naturze. Bo my po prostu tacy jesteśmy. Ja też, choć przynajmniej staram się nie tracić poczucia rzeczywistości, co z resztą nie zawsze mi wychodzi. Dobra. Wystarczy tej etiudy rewolucyjnej. Ja tu gadu-gadu a na moim biurku leżą najnowsze i prawdopodobnie najwydajniejsze na świecie karty graficzne przeznaczone do gier.

Potwory ze stajni nVidia (oficjalna maskotka GF4) łaskawie pozwoliły się porównać z jednym z dotychczasowych leaderów high-end'u: układem Radeon 8500, który został wyprodukowany przez jedynego żyjącego obecnie realnego konkurenta tajwańskiego potentata w tym segmencie rynku, kanadyjską firma ATI. Zgodnie z własnymi przekonaniami postaram się nie tylko zawęzić testy do nudnego (przynajmniej dla mnie) produkowania tabelek z wynikami, ale postaram się dostrzec również to, co uprzyjemnia bardziej klasyczne wykorzystanie karty graficznej. Apetyt na wszelkiego rodzaju porównania mam duży, ale tym razem chciałbym jak najszybciej sprostać wymogom serii ponaglającej mnie korespondencji od fascynatów, którzy nie chcą czekać na wyniki długich i skrupulatnych testów. W imieniu swoim i kolegów z redakcji zapewniam, że jeszcze nie raz powrócimy do tematu GF4 a dziś chcę przedstawić jedynie wstępne wrażenia i wyniki, jakie zdołałem zebrać w czasie tygodnia użytkowania karty.

Teoria.

Najpierw przedstawię wybrane parametry kart referencyjnych (w kwestii taktowania mogą być różnice pomiędzy producentami) w formie tabelki. Głównie chodzi o dobór uwzględniający różnice. Części określeń nawet nie starałem się tłumaczyć (zainteresowani będą wiedzieli, o co chodzi).

Porównując GF4 ze swoim poprzednikiem, na pierwszy rzut oka wydaje się, że nVidia nie dokonała daleko idących zmian w architekturze:

- Nie wprowadzono elementów umożliwiających pełne pokrycie procedur Direct3D 8.1 (głównie chodzi o wsparcie Pixel Shader w wersji 1.4), którymi szczyci się Radeon 8500.

- Nie zwiększono ilości strumieni renderowania czy ilości jednostek teksturujących na strumień.

- Nadal maksymalna ilość tekstur możliwych do nałożenia w jednym przebiegu wynosi 4.

- Brak wsparcia dla N-Patches.

Z drugiej strony nie można powiedzieć, że dokonane zmiany nie mają istotnego wpływu na walory użytkowe i wydajność nowych kart:

- Dzięki optymalizacji architektury układu możliwe było zwiększenie jego taktowania o niebagatelne 25% bez zmiany technologii (0.15 um) i przy zwiększeniu powierzchni układu o 5%.

- Wykorzystanie nowych generacji układów pamięci pozwoliło na zwiększenie ich taktowania o 30%. To duży skok i tym ważniejszy, że GeForce zawsze był "głodny" ich przepustowości. Nowe pamięci nie wymagają radiatorów.

- Lightspeed Memory Architecture II: Wprowadzono szereg istotnych zmian w procesach optymalizacji i zarządzania strumieniem przesyłanych do i z pamięci danych oraz działania Z-bufora. Preodczyt, pamięci podręczne: pixel, vertex, primitives i texture, bezstratna kompresja Z-bufora wraz z nowym algorytmem wykrywania obszarów niewidocznych i szybkim jego zerowaniem.

- nfiniteFX II: wprowadzono dwie równolegle działające jednostki Vertex Shader (na wzór układu NV2A wykorzystywanego w konsoli X-Box) a jednostka Pixel Shader obsługuje sprzętowo zakres wersji do 1.3 (w stosunku do 1.1 ma on kilka dodatkowych funkcji głównie związanych z lepszym wykorzystaniem Z-bufora, GF3 realizował je programowo).

- nView: niezależna obsługa dwóch ekranów poprzez dwa wbudowane układy Ramdac 350MHz.

Oględziny.

1) Prolink PixelView GeForce4 Ti 4600

Karta Prolink PixelView GeForce4 Ti 4600 (kliknij, aby powiększyć)

Prolink PixelView GeForce4 Ti 4600 przyjechał do mnie w opakowaniu zastępczym i ze sterownikami na płytce CD-R. Typowy egzemplarz testowy lub przeznaczony na wystawę. Tym nie mniej jest to ten sam sprzęt, który aktualnie wchodzi do sprzedaży. Nie mogę za to nic powiedzieć na temat zawartości pudełka w zestawie, który będzie dostępny w sklepach (oprogramowanie dodatkowe, przejściówki, kabelki, instrukcje). Najważniejsze dwa elementy "sprzętowe", czyli sama karta Prolinka oraz przejściówka VIVO były w paczce, więc do szczęścia nic mi w zasadzie więcej nie potrzeba. Pierwsze spojrzenie na kartę budzi respekt i jednocześnie pewne obawy. Karta jest sporej wielkości. Powiem więcej. Jest naprawdę duża. Wygląda to tak jakby do GF3 dołożyć jeszcze parę centymetrów z przeznaczeniem na stabilizację zasilania. W przypadku wielu płyt należy kartę wkładać na samym końcu a przedtem przemyśleć dobrze ułożenie kabli i taśm do urządzeń (np. w Solteku 75DRV2 należy bardzo uważać na taśmę FDD, najpierw ją wkładamy, potem zawijamy w górę i na końcu delikatnie dociskamy kartą wykorzystując wgłębienie przed kondensatorem). Może się również zdarzyć, że do jakiejś mniejszej płyty po prostu nie wejdzie (słyszałem już takie informacje, ale osobiście nie mogę ich jeszcze potwierdzić, chodzi np. o popularnego Epox'a 8KHA+ któremu przeszkadza jeden kondensator w instalacji niektórych kart GF4Ti). Jako, że karta jest duża i ciężka to miłym akcentem byłoby posiadanie płyty z zaczepem mocującym na AGP. Zawsze pewniej. Największym jednak minusem dużych kart jest znaczące utrudnienie cyrkulacji powietrza wewnątrz obudowy. Powinni o tym pamiętać wszyscy Ci, którzy wyciskają z elementów komputera ósme poty nie przejmując się dodatkowymi elementami wentylacyjnymi ani wielkością obudowy. Z drugiej strony bierzmy pod uwagę, że dodatkową przestrzeń na karcie zabiera blok zasilania i prawdopodobnie właśnie dzięki niemu możemy cieszyć się stabilną pracą nawet na słabszych płytach głównych.

Karta Prolinka niczym się nie różni od referencyjnych kart nVidia (przygotowanych przez Visionteka), które można było oglądać w pierwszych testach internetowych GF4 oprócz typowego dla Prolinka koloru PCB. Mamy więc ten słynny cooler z wydmuchem bocznym i 128MB pamięci opartej na kostkach Samsunga 2.8 ns w obudowie BGA bez dodatkowych radiatorów. Swoją drogą ten nowy rodzaj kości pamięci już zaczyna podbijać świat i zobaczymy je wkrótce w większości wydajniejszych kart na rynku oraz w modułach DDR pamięci systemowej. Kartę wyposażono w wyjście analogowe VGA, cyfrowe wyjście DVI (LCD) oraz 9-pinowe gniazdo zespolone PS do operacji VIVO (TV/Video In/Out) poprzez odpowiedni kabelek (konkrety będą w części o VIVO). Warto też zwrócić uwagę na nietypowe, duże gniazdo monitorowe, takie same jak stosuje w swoich kartach Matrox. Karta jest taktowana referencyjnie, czyli 300MHz rdzeń i 325MHz pamięć (transfer DDR 650MHz). Całością zarządza BIOS w wersji 4.25.00.22.21.

(kliknij, aby powiększyć)

2) Gainward GeForce4 PowerPack!!! Ultra/750 XP "Golden Sample"

Karta Gainward GeForce4 (kliknij, aby powiększyć)

Gainward GeForce4 PowerPack!!! Ultra/750 XP "Golden Sample" występował w wersji bardzo zbliżonej do tej, jaką będzie można zobaczyć na półkach sklepowych. Już sama karta wyposażona jest bardzo bogato. Po raz pierwszy spotkałem się z dwoma wyjściami DVI na śledziu. Możliwa jest praca karty z dwoma monitorami LCD podłączonymi łączem cyfrowym. Mało tego. W zestawie są dwie przejściówki wykorzystujące analogowy sygnał, który również wyprowadzono na DVI. ożemy więc podłączyć dwa klasyczne lampowe monitory analogowe (lub oczywiście LCD analogowo). Całości dopełnia zespolone wyjście-wejście VIVO (takie same jak w karcie Prolinka) i odpowiedni kabelek wielofunkcyjny. Dzięki takiemu rozwiązaniu wyjść karta Gainwarda umożliwia uzyskanie wszystkich możliwych konfiguracji wzajemnych urządzeń do wyświetlania obrazu, na jakie zezwala specyfikacja nVidia. Do chłodzenia układu graficznego wykorzystano ten sam cooler jak w karcie Prolinka natomiast dodatkowo pokryto pamięci radiatorami.

W zestawie znajduje się również czteroportowa (jeden wewnętrzny, trzy zewnętrzne) karta PCI FireWire (IEEE1394) oparta na układzie VIA VT6306 wraz z kablem połączeniowym. Oprogramowanie zajmuje cztery płyty CD. Pierwsza zawiera sterowniki i programy narzędziowe (m.in. Expertool). Druga grę Serious Sam. Na kolejnych dwóch płytach znajduje się zestaw oprogramowania multimedialnego firmy InterVideo: programowy odtwarzacz DVD (WinDVD), oprogramowanie do edycji filmów (WinProducer) oraz działający w czasie rzeczywistym kodek Mpeg-1/2 (WinCoder). Kompletu dopełniają instrukcje angielskie: jednokartkowa do karty FireWire oraz książeczka Gainward Quick Start.

Dodatkowo dystrybutor załączył polską instrukcję instalacji i obsługi kart Gainward serii GF4Ti, na którą chciałbym zwrócić szczególną uwagę, bo moim zdaniem warta jest tego. Instrukcja wydrukowana została w kolorze na zwykłych kartkach A4 połączonych zszywaczem, ale zarówno treść jak i forma tekstu wzbudza duże uznanie. Na 27 stronach znajdziemy instrukcję montażu karty, instalacji oprogramowania, opis ustawień sterownika i managera pulpitów, opis narzędzia Expertool, dodatkowe dane techniczne, postępowanie przy wystąpieniu problemów, słowniczek pojęć a nawet instrukcję instalacji karty FireWire. Wszystko okraszone zostało sporą ilością czytelnych, kolorowych zrzutów ekranu i rysunków poglądowych. Pozostaje tylko mieć nadzieję, że inni dystrybutorzy pójdą w tym samym kierunku i to nie tylko w odniesieniu do tych najdroższych modeli kart.

Zasadniczo w kwestii zawartości pudełka jest jedna, aczkolwiek bardzo istotna różnica pomiędzy zestawem, który dostałem do testów a docelowym produktem. Zabrakło okularów 3D, które w tym wypadku będą standardowym wyposażeniem. W takim zestawie produkt Gainwarda wydaje się nie do przebicia pod względem bogactwa wyposażenia. Oczywiście wielkość karty jest taka sama jak i innych GF4Ti, ale czerwony kolor jest już typowy dla Gainward'a. Kartą zarządza BIOS 4.25.00.21.01. Co do narzędzia Expertool to muszę przyznać, że traktuję go podobnie jak WinFox Leadteka. Jest pewnym przejawem aktywności producenta w dziedzinie oprogramowania o czysto marketingowym charakterze. Nie wnosi specjalnie nic więcej poza standard wyznaczony przez drivery (może poza flasherem) ale przynajmniej świadczy o staraniach producenta aby dostarczyć produkt odróżniający się od standardu. W trakcie instalacji samych driverów mamy też możliwość podkręcenia programowego zegarów do 310/680MHz (rdzeń/pamięć).

(kliknij, aby powiększyć)

Platforma testowa.

Skoro benchmark kocha GF4Ti 4600 to postanowiłem pójść na lep fps'ów i punktów poprzez zapewnienie kartom jak największego wsparcia od strony procesora. Zdaję sobie sprawę z tego, że różnica wyników związana z platformą tak naprawdę nijak ma się do realnych możliwości kart. Szumne "skalowanie układów graficznych z procesorem" w przypadku chipów "pure device" jest w znacznym stopniu nieporozumieniem. Powyżej pewnej klasy procesora (np. Duron/Celeron 1GHz) skalują się jedynie niektóre gry, które programiści obarczyli zrzuceniem części obliczeń na jednostkę centralną oraz karty oparte na sterownikach hybrydowych lub po prostu niedopracowanych. Reszta to głównie "pompowanie" samego wyniku testu, bo opiera się on na średnich wartościach fps.

Na prostych układach karta "czeka" na procesor, więc obniżają się wartości maksymalne. Oczywiście bez żadnego wpływu na realne odczucia grającego, bo poziom zmian przebiega znacznie powyżej progu płynności. Im bardziej zmusimy kartę do wysiłku tym rzadziej wyniki będą uzależnione od platformy. Aby w ogóle mieć obraz skalowalna kart musimy robić pomiary w jak najwyższym trybie. Oczywiście w związku z tym, że zależy on głównie od czynników poza samym układem graficznym (np. tryby monitora czy ilość lokalnej pamięci na karcie) to im wydajniejsza karta tym większy wpływ platformy na wynik. Tryb 1024x768x32, który dla "wczorajszych" kart był nie lada wyzwaniem dla nowych nie stanowi żadnego problemu i możemy zaobserwować różnicę wyników w zależności od np. taktowania procesora, której na starszych kartach nie było. Czy oznacza to, że nowsze karty bardziej skalują się z procesorem? Nie. Po prostu świadomie, poprzez zbyt niski tryb graficzny uzależniliśmy wynik od platformy. Wynik wzrasta, ale realnie gra się tak samo. To wszystko są oczywiście uogólnienia, aby zagadnienie było łatwiejsze do zrozumienia no i nie odnoszą się do wyjątków, o których wcześniej wspominałem. Po co to piszę? Otóż wielokrotnie się spotkałem z proponowaniem przez sprzedawców klientom za tą samą cenę zestawu z wydajniejszym procesorem, ale za to ze słabszą kartą graficzną, co było podparte wynikami testów w trybach niższych niż możliwości tej lepszej karty. Zgroza. No dobra. Gra to jedno a poziom zadowolenia użytkownika z wyników testów to drugie. Wracam na ziemię. Łup. Jestem. I chcę dużo punktów. Płacę i wymagam.

Dzięki uprzejmości firmy Sirius pożyczyłem płytę Abit BD7 (i845D) wraz z procesorem Intel Pentium 4 1.8a (Northwood) oraz 512MB pamięci DDR PC2100. Nie ukrywam, że zamierzałem to jeszcze podkręcić w celu uzyskania jeszcze wyższych wyników. Jak szaleć to szaleć. Chciałem widowiska. Niestety przysłany egzemplarz płyty pechowo okazał się uszkodzony i to w dosyć nietypowy sposób. Kategorycznie odmawiał stabilnej pracy, jeśli szyna pamięci miała taktowanie wyższe niż ok. 120MHz (nie mylić z FSB). Nie można było nawet uruchomić zestawu na ustawieniach domyślnych, zgodnych ze specyfikacją, czyli procesor 1.8GHz przy taktowaniu szyny 100MHz a pamięć 266MHz (taktowanie szyny pamięci 133MHz). Można było jedynie ręcznie wymusić synchroniczne taktowanie pamięci, co jak wiadomo kończy się dla P4 założeniem kagańca (jest bardzo czuły na wydajność pamięci). Trudno. I tak słabizną tej platformy nie można nazwać. Nawet przy takim spowolnieniu. Jedynie pozwoliłem sobie na ustawienie FSB (i pamięci) na wartość 111MHz, co daje ładną optycznie wartość 2GHz dla procesora. Tak więc niemal wszystkie testy przeprowadziłem na czymś co szumnie nazwałem P4 2GHz a osiągane wyniki (średnio licząc w zależności od gry) były zbliżone do tych, które można wycisnąć z agresywnie ustawionej, nowej platformy opartej na AMD XP 1700+.

Karty GeForce testowałem w oparciu o nowiutkie, ściągnięte z Internetu, oficjalne sterowniki v28.32. Dodatkowo przy podkręcaniu i odkręcaniu oraz w celu wymuszenia filtrowania anizotropowego w D3D posługiwałem się programikiem RivaTuner (http://www.nvworld.ru). Oczywiście vsynch był wyłączony. Pozostałe parametry pozostawiłem na wartościach domyślnych sterownika. ATI Radeon, 8500 który był użyty do porównań pracował na domyślnym taktowaniu 275/550MHz a wykorzystałem supportowane sterowniki referencyjne ATI v9021 (Win9x) oraz v6037 (WinXP).

Uruchomienie.

Na pierwszy ogień poszedł Prolink. Pomimo wielkości karta nie stanowiła żadnego problemu dla stosunkowo dużej płyty Abita a zatrzask na AGP dodatkowo ją unieruchomił. Instalacja sterowników przebiegła bez najmniejszych problemów i z marszu można było przystąpić do testów. Jakość obrazu 2D na pulpicie Windows stała na przyzwoitym poziomie (należy pamiętać, że odnosi się to zawsze do konkretnego egzemplarza). Odrobinę gorsza ostrość i nasycenie kolorów niż na Radeonie, ale moim zdaniem całkowicie akceptowalny, solidny poziom dobrego GF3. Co ciekawe poprzednio testowany przeze mnie Prolink GF4MX440 miał odrobinę lepszą jakość ale był to wybitnie dobry egzemplarz. Generalnie brak uwag. Fikuśny cooler pracuje dosyć cicho (zdecydowanie ciszej niż np. Leadtek GF4MX440) dając odgłos zbliżony do tego, czym raczą nas karty ATI Radeon 8500 (jest może minimalnie głośniejszy). Mnie w każdym razie nie przeszkadzał. Karta w czasie pracy rozgrzewa się bardzo mocno (cała), ale nie miało to wpływu na pogorszenie stabilności. Przy podkręcaniu Prolink pracował stabilnie do 315/700MHz (domyślnie 300/650MHz) co nie jest może wielkim osiągnięciem ale należy pamiętać, że jest to normalne dla najwyższych modeli kart graficznych. Przecież już sam producent podkręcił ją za nas.

Kolej na Gainwarda. Wkładam kartę. Do pierwszego złącza DVI wciskam jedną z dwóch przejściówek a do niej przypinam monitor. Można jechać. Pomimo zbliżonego kształtu wentylator Gainwarda działa wyraźnie głośniej od Prolinka. Trudno jeszcze powiedzieć czy to świadomy dobór producenta czy trafiłem na taki egzemplarz. Tym nie mniej nie jest on tak głośny, aby było to specjalnie denerwujące dla przeciętnego użytkownika (niektórzy akceptują nawet zdecydowanie głośniejsze) a i ton nie należy do tych wykręcających mózg. Dla mnie osobiście jest on jednak trochę za głośny. Wrzucenie driverów i przystępuję do oględzin obrazu. Prawdę mówiąc byłem trochę zaniepokojony faktem braku klasycznego złącza VGA (przynajmniej jednego), co wynika z braku zaufania do przejściówek. W wielu przypadkach dodatkowe złącze pogarsza jakość obrazu. Nie tym razem. Testowany Gainward pomimo adaptera wyświetla ostrzejszy obraz niż Prolink. Jestem pod wrażeniem. Karta jest nieco wyżej taktowana niż specyfikacja nVidia. 305/660MHz to śmieszna różnica, ale przy porównaniu z innymi kartami GF4Ti 4600 zawsze ten "fps" więcej. Po podkręceniu pracowała stabilnie przy 320/730MHz. Zaraz, zaraz. Przecież w nazwie jest symbol 750, co oznacza u Gainwarda możliwości pracy pamięci. Dystrybutor zapewnia, że dzieje się tak, dlatego, że testowana karta jest w zasadzie modelem przedprodukcyjnym a to, co będziemy kupować w sklepach spełni założenia taktowania (750MHz).

3DMark2001 SE.

Zacznijmy od zajęć obowiązkowych.

Testowanie domyślnym testem 3DMarka kart tej klasy jest kiepskim pomysłem. Jeszcze gorszym jest wyciąganie z nich wiążących wniosków. Wynik w znaczącym stopniu opiera się na wydajności platformy testowej i następuje sztuczne zmniejszenie różnic pomiędzy testowanymi kartami. Pomimo tego GF4Ti 4600 i tak miażdży konkurencję. Jedynie w teście Nature Radeon uzyskuje niewielką przewagę. Miłośnik entuzjazmowania się samym wynikiem może być zawiedzony. Magiczna bariera 10000 punktów nie została przekroczona. Nie ma sprawy. Zmieniamy platformę na VIA KT266a + AMD XP 1700+ (3DMark szczególnie lubi AMD). Najpierw ustawienia znamionowe bios'a. Cienko. Zmieniam wszystkie parametry na jak najbardziej agresywne. Pal licho stabilność. Chcę punktów. Lepiej. Proszę zwrócić uwagę na różnicę. W tym trybie pomiar jest tak czuły na zmiany ustawień, że wręcz czuję jak karty się "nudzą". Dochodzimy do wymarzonego wyniku. Podkręcam procesor do częstotliwości taktowania modelu 2000+. Prawie 10500 punktów. Mamy więc kartę która bez żadnego podkręcania na procesorze również działającym znamionowo osiąga bez wysiłku "magiczny" wynik. To powinno każdemu entuzjaście złagodzić żal utraty znaczącej ilości gotówki.

Przejdźmy do bardziej sensownego testu. Obydwie karty osiągają w 1600x1200x32 wynik powyżej 5000 punktów. Wygląda na to, że nawet taka rozdzielczość nie jest w stanie w tym teście zmusić kart do maksymalnego wysiłku. Przewaga GF4Ti 4600 nad Radeonem 8500 jest tak duża, że nie pozostawia wątpliwości, kto tu jest silniejszy. Jest to spektakularne zwycięstwo, bo najnowsze ATI zawsze doskonale radziło sobie z 3DMarkiem. Na osłodę pokonanym pozostaje fakt, że kosztują połowę mniej a średnia różnica wyników sięga "tylko" 20%.

Quake 3 Arena.

Kolejny żelazny punkt programu testów.

Coż. Skończyła się skala mojego monitora a GF4 nawet nie dostał zadyszki. Radeon wprawdzie również i w 1600x1200x32 nie ma problemów, ale można już mówić o różnicy klas wydajności. Niestety Quake3 powinien już odejść na zasłużoną emeryturę. Nie jest już w stanie stawiać opór nowym kartom. Osiągnięcie w Pumped.dm3 średnio 50 fps oznacza brak szarpania. Z punktu widzenia gracza nie ma różnic w jakości grania na porównywanych układach pomimo tak odbiegających wyników. Warto zwrócić uwagę na lepszą jakość tekstur s3tc, choć moim zdaniem wyglądają wciąż gorzej niż na Radeonie (porównanie: s3tc.zip).

Unreal Tournament.

W zasadzie nie wiem, po co zawsze zamieszczam wyniki testów UT. Ta gra nie nadaje się na benchmark. Wyniki są mało reprezentatywne i nieprawidłowo reagują na zmiany parametrów pomiaru.

W OpenGL + S3TC (tekstury z drugiej płytki) można dowolnie zmieniać tryb. Zawsze tak samo płynnie i z powalającą jakością obrazu. GF4 w odróżnieniu od poprzedników z rodziny GeForce ma poprawioną obsługę kompresji DXT1, więc w końcu uzyskiwany efekt wizualny jest nie gorszy niż na ATI. O innych API należy zapomnieć. Ten tryb jest po prostu nie do przebicia. Znowu brak realnych różnic. Za mocne karty. Obie.

Zupełnie inaczej wygląda to w D3D. Wyraźnie widać problemy kompatybilności. Sprawę dodatkowo pogarsza przejście na Windows XP. Zdecydowanie szkoda czasu i oczu na to API w UT.

Return to Castle Wolfenstein.

Zapomnijcie o testach w 1024x768x32. To nie ma sensu. Odczuwalna przewaga GF4 w 1600x1200x32.

Medal of Honor Allied Assault.

Jedna z ciekawszych gier ostatniego "wysypu". Nie ma niestety procedury testowej, ale prowadzę własną statystykę możliwości kart w tej grze. Nazwałem ją umownie Mohaa min. W zasadzie nawet GF2 nie ma problemu z płynną grą na maksymalnych ustawieniach w 1024x768x32. Problem występuje dopiero w konkretnej misji przebiegającej w lesie (padający śnieg, bunkry). Na tym układzie "wykładają" się wszystkie karty, bo programiści zafundowali nam taką gęstość siatki wielokątów, że nawet Radeon 8500 czy GF3 Ti500 dostają zadyszki. Nie pomaga nic oprócz radykalnego zmniejszenia ilości szczegółów. Moja metoda zrobienia pomiaru opiera się na wychwyceniu minimalnej ilości fps w konkretnym miejscu w grze (1024x768x32, ustawienia na maksymalną jakość obrazu). Nie twierdze, że jest to min. Ilość fps w całej grze. Ważne jest to, aby niezmienne były warunki pomiaru dla różnych kart. W takim teście Radeon 8500 "schodził" do 13 fps natomiast GF4 do 26 fps. Różnica jest boleśnie odczuwalna, bo zawiera w sobie granicę płynności ruchu (to są chwilowe wartości fps). Producenci gry chyba jednak przesadzili, bo 26 fps na GF4 w 1024x768x32 woła o pomstę (zrzut wykonany przy okazji testów GF4MX).

Medal of Honor (kliknij, aby powiększyć)

Max Payne.

Wyniki brzmią groźnie, ale gra się znakomicie na obydwu kartach. W 1600x1200x32 Radeon jednak "wymięka". Coż. Trzeba się z tym oswoić. Test wykonywany jest zgodnie z instrukcją ze strony www.3dcenter.de.

Serious Sam

Predefiniowane ustawienia Quality. Wyniki potwierdzają dominację nVidia ale w grze jakoś tego nie odczułem. Również obraz generowany przez ATI wydawał się lepszy.

Giants.

Na tym benchmarku poległ niejeden układ. Szczególnie chętnie robię porównania pomiędzy systemami. GF4 znacząco słabnie w Windows XP podobnie jak kiedyś Radeon na starszych sterownikach. Widać, że nVidia ma jeszcze (wbrew powszechnej opinii) sporo do poprawienia. Jeśli ktoś chciałby sobie zbudować wykresy chwilowych wartości fps w demie to załączam pakiet z wynikami (giants.zip).

Aquanox.

Test moim zdaniem wart uwagi. Procedura pomiaru jest nieco dziwna (www.3dcenter.de), ale osiągane wyniki są stabilne i prawidłowo reagują na zmiany. Po raz kolejny nowy GF zdeklasował rywala. Mam nadzieję, że słynny Aquamark dostępny jak na razie jedynie dla wybranych stanie się niedługo dobrem publicznym. Aquanox wykorzystuje sporo możliwości D3D 8.0 i lepiej odzwierciedla zachowanie kart w nowych grach (sprawdzałem też nowy test Commanche4 ale moim zdaniem nie nadaje się do testowania kart, bo trudno z niego wyciągnąć sensowne wnioski).

SpecViewPerf.

Nie znam się na profesjonalnej grafice 3D, więc trudno mi to zinterpretować. Zainteresowani pewnie są w stanie wyciągnąć odpowiednie wnioski, choć z tego, co słyszałem lepiej używać do testowania konkretnego softu, który wykorzystuje się do pracy niż tego dosyć w sumie starego "syntetyka".

Pełnoekranowy antyaliasing i filtrowanie anizotropowe.

Ważny temat. Te dwie funkcje mogą w pewnym zakresie poprawić jakość wyświetlanych gier bez wsparcia z ich strony (wymuszenie na sterownikach). Filtrowanie anizotropowe ma moim zdaniem przy trybach do jakich jesteśmy już przyzwyczajeni (1024x768 i więcej) większe znaczenie niż eliminacja "schodków" (fsaa) ale oczywiście najlepiej jeśli uda nam się utrzymać płynność przy załączeniu obydwu efektów.

(kliknij, aby powiększyć)

GF4Ti udostępnia kilka trybów antyaliasingowych: 2x, Quincunx, 4x oraz 4xS (tylko dla Direct3D). nVidia stara się zwrócić szczególną uwagę na ten efekt bo ze schematu chipa wynika, że zajmuje on pokaźną część rdzenia. Udało się uzyskać stosunkowo mały spadek wydajności szczególnie dla trybów 2x i Quincunx. Quincunx znacznie lepiej wygładza "schodki" niż 2x przy tym samym frame rate. Niestety warto go wspomóc filtrowaniem anizotropowym, bo mocno rozmywa tekstury. Znacznie lepszy efekt uzyskuje się przy 4x (mniejsze rozmycie przy tym samym wygładzaniu) ale rewelacją jest dopiero 4xS (przynajmniej jak dla mnie). Szkoda, że tylko w D3D no i niestety koszt jest spory. Obraz wygląda tak jakby ożenić fsaa 4x z anizotropem 8x (może tak z resztą niejawnie jest robione). Zestaw przykładowych zrzutów zawarłem w pakietach zip (cmr2.zip). Wyniki są pobierane w trybie 1024x768x32.

Jak widać dopiero 4x powoduje znaczące ograniczenie wydajności. Również niewielka różnica pomiędzy 4x i 4xS skłania do preferowania tego drugiego, jeśli oczywiście mamy zachowaną płynność renderowania. Model przyjęty przez nVidia lepiej filtruje schodki na połączeniach tekstur za to nie wnika w same tekstury. Siłowy supersampling ATI z kolei lepiej zachowuje samo wnętrze tekstur. Należy również zwrócić uwagę na to, że metoda ATI opiera się na próbkach losowych i nieruchome zrzuty ekrany nie zawsze dobrze odzwierciedlają realną jakość w grze. Zebrałem również wyniki dla Aquanoxa, ale nie mogę porównać z Radeonem bo w tej grze nijak nie mogłem na nim uzyskać FSAA.

Przykład z Aquanox pokazuje, że w przypadku nowych gier stosowanie FSAA mija się w ogóle z celem, bo stanowi nawet dla GF4 zbyt duże wyzwanie.

(kliknij, aby powiększyć)

Bardziej wartościowym efektem jest dla mnie filtrowanie anizotropowe. Wyostrza tekstury niezależnie od trybu "wyciągając" detale, które normalnie nikną przy oddaleniu od obserwatora. W wielu przypadkach może z powodzeniem zastąpić zwiększanie rozdzielczości a nawet dawać lepszy efekt.

(kliknij, aby powiększyć)

Ta tabelka powinna z kolei usatysfakcjonować posiadaczy Radeonów. nVidia przyjęła inny algorytm filtrowania, który niestety potężnie wpływa na frame rate. ATI stara się filtrować tylko te tekstury, które tego wymagają (im większa odległość tym większa potrzeba filtrowania) co zbawiennie zmniejsza zaangażowanie układu w cały proces. Oczywiście powoduje to czasem nieprawidłową detekcję i przy pewnych kątach nachylenia tekstur filtrowanie potrafi zaniknąć. Do wad filtrowania ATI należy również to, że w OpenGL tracimy jednocześnie z włączeniem anizotropia filtrowanie trzyliniowe (w D3D również znika ono też na GF4). Pomimo tych ograniczeń efekt w realizacji ATI jest zdecydowanie bardziej użyteczny a drobne zakłócenia, o których wspomniałem są trudne do wykrycia w normalnej grze.

Zastrzeżenia w stosunku do obciążenia anizotropem mają sens tylko wtedy, gdy karta przestaje się wyrabiać w konkretnej grze. Jeśli mamy nadwyżkę mocy to nic nie staje na przeszkodzie, aby był on włączony w jak najwyższym trybie. Warto.

Najlepiej oczywiście połączyć oba efekty. Optimum wydajności i jakości to dla GF4 Quincunx + anizo x4 (najlepiej x8).

Jak widać następuje wyrównanie z Radeonem ale nie ma co ukrywać, że obraz na GF4 jest trochę lepszy (lepsze filtrowanie schodków przy podobnej jakości tekstur). W Aquanox lepiej w ogóle nie bawić się w "ulepszacze".

Oczywiście załączam kolejny pakiet zrzutów dla porównania obrazu (draghotic.zip). Generalnie osobiście w zależności od gry i możliwości uzyskania płynności preferowałbym na GF4 następujące łączenie efektów: 4xS w D3D lub 4x + anizo 8x dla najmniej wymagających gier, Quincunx + anizo 8 (Ew. 4x) dla nieco bardziej wymagających lub odpuszczenie obydwu efektów dla tych najnowszych. W przypadku Radeona anizo x16 w zasadzie w ogóle bym nie wyłączał a przy prostszych grach włączałbym dodatkowo Fsaa 4x (Ew. 2x). Szczególnie w samochodówkach, dla których Radeon wydaje się wręcz stworzony.

Podkręcanie.

Tu powinienem napisać tylko jedno. Podkręcanie GF4Ti 4600 nie ma większego sensu. Szczególnie odradzam dalsze zwiększanie taktowania rdzenia. On naprawdę grzeje się potężnie. Z drugiej strony przecież dla niektórych liczy się każdy fps, więc trzeba zrobić kilka pomiarów ku radości entuzjastów.

Cóż. 5-10% zwyżki wyników raczej nie jest w stanie być odczuwalne przez grającego. Może się jedynie przydać w celu osiągania rekordów pomiarowych lub uspokojenia sumienia w razie konfrontacji ze znacznie tańszymi kartami 4400, które prawdopodobnie więcej zyskają na podkręceniu.

Odkręcanie.

Wydaje mi się, że jednym z ciekawszych testów jest próba zasymulowania zachowania tańszego modelu 4400 i 4200 który w założeniach ma zastąpić świetnie sprzedający się GF3Ti200. Model 4400 różni się tylko taktowaniem, które wynosi 275/550MHz. Model 4200 ma być taktowany 225/500MHz i mieć 64MB pamięci lokalnej. Jako, że różnica w ilości pamięci ma niewielki wpływ na wyniki testów to można z pewnym przybliżeniem określić działanie przyszłych kart przez obniżenie taktowania najsilniejszego modelu GF4Ti 4600 (300/650MHz).

Jak widać w testach 1600x1200x32 model 4200 (już przy 64MB) osiągać powinien podobne wyniki jak Radeon 8500. Będzie więc znacząco wydajniejszy niż aktualne GF3Ti 200 które nie są w stanie zbliżyć się nawet do R8500LE. Oczywiście dojdzie to tego jeszcze kwestia możliwości podkręcania najsłabszego modelu (teoretycznie powinny być spore). Wydaje się jednak, że karty GF4Ti 4200 będą przebojem (powinny być dostępne w cenie nieco poniżej 1000 zł). Oczywiście nie sądzę aby Radeon 8500 łatwo sprzedał skórę, ale przynajmniej w tej klasie cenowej będzie większy wybór dla kupującego.

nView i VIVO.

Szerzej o możliwościach nView pisałem już przy okazji testów GF4MX 440. Nic się w tym względzie nie zmieniło. Przypomnę tylko, że nView jest oprogramowaniem instalującym się razem ze sterownikiem umożliwiającym zarządzaniem pracą większej ilości pulpitów poprzez wykorzystanie dualnych możliwości karty. Funkcjonalnie nView zbliżone jest do HydraVision, która obsługuje ekrany dualnych Radeonów. Tym nie mniej produkt nVidia jest moim zdaniem nieco łatwiejszy w konfiguracji (np. kwestia wizard'a) i dodatkowo ma funkcję automatycznego wyświetlania pełnoekranowego na drugim wyjściu.

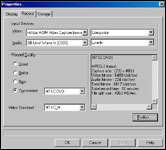

Za wyświetlanie obrazu na telewizorze w GF4Ti odpowiadają te same układy co we wcześniejszych modelach nVidia. Zobaczymy więc znane Conexanty, Chrontele i Philipsy. Szkoda, że producent nie zdecydował się zrobić własnego, zewnętrznego układu w oparciu o ten wbudowany w rdzeń GF4MX bo oceniam go nieco lepiej. Tym nie mniej stosowany od lat ATI Rage Theater wciąż dysponuje nieco lepszym obrazem. Wszystko wskazuje na to, że wejście telewizyjne (VIVO) również będzie realizowane przez znane wcześniej układy Philips SAA 7108E, o których nie mam najlepszego zdania. Tym nie mniej należy zauważyć, że najnowsze sterowniki WDM 1.11 (obsługa wejścia) znacząco poprawiają parametry capture w stosunku do tego co jeszcze kilka miesięcy temu nam oferowały.

Sterownik umożliwia przechwyt sygnału analogowego z rozdzielczością do 720x480 w 30 klatkach/s (standard NTSC) i nie ma możliwości capture w pełnym PAL (576 linii). Co ważniejsze próby łapania obrazu w standardzie avi tak przydatnego w edycji kończyły się u mnie zawsze utratą sporej części ramek. Pozostaje oczywiście bezpośredni zrzut do mpeg, który na najnowszych, programowych kodekach ma zupełnie przyzwoitą jakość. Ogólnie nie polecam tych kart amatorom półprofesjonalnej edycji własnych, wysokiej jakości filmów (zrzut, cięcie, efekty, modyfikacje, komentarze itd.) przy wykorzystaniu kamery analogowej natomiast wejście powinno spełnić oczekiwania w funkcji magnetowidu cyfrowego (zrzucić kompletny materiał, przyciąć, przekonwertować).

(kliknij, aby powiększyć)

Obie testowane karty wyposażone są w układ Philips SAA 7108E, który realizuje funkcje VIVO. W komplecie z kartami załączono specjalny kabelek wyprowadzający zestaw wyjść i wejść w standardzie Composite i S-Video. Prolink zdecydował się na trzy wtyczki oraz dodatkową przejściówkę do wejścia Composite. Gainward natomiast miał wszystkie cztery wtyczki (moim zdaniem to wygodniejsze rozwiązanie) na jedynym kablu, ale nie zostały one opisane (tak jak w Prolinku) i musiałem się odwołać do instrukcji. Możliwości capture są w obydwu kartach takie same natomiast w wyświetlania obrazu na TV lepszy okazał się Gainward. Obraz jest stabilniejszy a kolory żywsze. Niestety wciąż nie wiem jak można włączyć overscan i pozbyć się czarnej ramki wokół wyświetlanego obrazu. Próbowałem jakiś rosyjski soft dla Phlipsów ale nie zadziałał.

(kliknij, aby powiększyć)

Do karty Gainwarda dołączony jest pakiet oprogramowania multimedialnego. Umożliwia prostą edycję (WinProducer), zrzut i konwersję do mpeg za pomocą wbudowanego kodeka programowego (WinCodec) oraz ich odtwarzanie (WinDVD). Całość jest odpowiednikiem funkcjonalnym pakietu Multimedia Center dołączanego do kart, ATI ale przebija go możliwościami edycyjnymi (choć z kolei blednie w tym zastosowaniu w porównaniu do produktów np. Ulead'a). Wydaje mi się jednak, że dobrze odpowiada klasie wejścia Philipsa i warto na niego zwrócić uwagę. WinCoder wyposażony jest w bardzo dobry kompresor RT do mpeg 1 i 2. Do wad zaliczyłbym brak schedulera (tak przydatnego przy funkcji magnetowidu) oraz brak możliwości korzystania z zewnętrznych kodeków i capture do AVI. WinProducer jest miniaturką edytora nieliniowego z podstawowymi możliwościami edycji, ale można wykorzystać kilka najprostszych efektów. WinDVD jest doskonale znanym programem do odtwarzania mpeg 1 i 2 oraz filmów DVD. Wykorzystano podstawową wersję OEM bez DTS'a i Dolby Headphones. Nie jest w stanie wykorzystać w pełni sprzętowej obsługi dekodowania DVD, jaką oferuje GF4, ale w trybie programowym charakteryzuje się bardzo małym obciążeniem procesora (ok. 20% na testowym Pentium4). Nie ma również problemu ze zbudowaniem wyjścia dźwięku w oparciu o karty wielokanałowe.

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Podsumowanie.

Nie ma dla mnie najmniejszej wątpliwości, że GF4Ti 4600 jest aktualnie najwydajniejszą kartą graficzną stworzoną do gier. W stosunku do GF3 zmiany mają bardziej charakter ewolucyjny niż rewolucyjny. Tym nie mniej dotyczą kilku ważnych funkcjonalnie aspektów. Najważniejsze jest znaczące poprawienie wydajności poprzez kilka technik zarządzania transferem danych pomiędzy układem i pamięcią. GF4 sprowadzony do taktowania GF3 wykazuje się znacznie większym frame rate a dodatkowo, dzięki wykorzystaniu nowych pamięci i optymalizacji rdzenia jest on również wyżej taktowany. Dla mnie osobiście jest on bardziej przejawem siły producenta niż realną potrzebą rynkową. Jednak znajdzie się bez wątpienia grupa zasobnych w pieniądze entuzjastów, dla których posiadanie mistrza jest na tyle ważne, że nie przejdą obok GF4Ti 4600 obojętnie. Nie będę ukrywać, że dla mnie nowe układy nVidia stanowią istotny krok naprzód w stosunku do poprzedniej generacji. To dobry produkt i wart zainteresowania. Jedyny naprawdę ważny element, który przewartościowuje tą opinię to cena.

Dla przeciętnego zjadacza gier wydaje się ona dosyć kosmiczna. Należy do tego podejść jednak nieco inaczej. Nowym produktem bazowym jest GF4Ti 4400 a wersja 4600 jest jego specjalną edycją stworzoną w celu zaspokojenia potrzeb elity. Jest to najwydajniejsza karta, która nie ma odpowiednika wśród produktów konkurencji, więc i cena nie podlega wolnorynkowej walce. W chwili obecnej nawet i słabsza wersja 4400 nie znajdzie odpowiednika np. u ATI. Ewentualnie może się to zmienić wraz z pokazaniem się układu RV250. Co do dalszych losów walki o rynek high-end to raczej nie spodziewałbym się istotnych zmian aż do końca tego roku. ATI R300 i nVidia NV30 mają być zerwaniem z dotychczasową linią układów i obsługiwać zapowiadany DirectX 9.0. Jako, że jego premiera prawdopodobnie będzie opóźniona to i nowe karty nieprędko ujrzą światło dzienne. Do aktualnych standardów istniejące karty są w sensie technologicznym zupełnie wystarczające. Z punku widzenia mniej zamożnej (lub może bardziej rozsądnej) części użytkowników ważne jest to, za jaką cenę (minimalną) można będzie kupić karty, które wykorzystają aktualny standard D3D 8.0 (lub 8.1) bo taka będzie potrzeba najbliższego roku.

Już wiadomo, że ze strony nVidia będą to modele GF4Ti 4200. Jak widać z przeprowadzonych aproksymacji nie będą to karty słabe bo wydajnością będą zbliżone do GF3Ti 500 a ceną z kolei bliżej im będzie do GF3Ti 200 (nieco droższe ale prawdopodobnie poniżej 1000 zł). Pojedynek z ATI Radeon 8500 w przeróżnych mutacjach (łącznie z modelami 230/366MHz w cenie GF4MX) nabierze więc nowych kolorów. Oczywiście analizując karty serii GF4Ti nie należy jedynie poruszać się w kwestii wydajności. Poprawiono zarówno funkcjonalność (nView) jak i jakość obrazu (np. kompresja tekstur). Do nieco słabszych stron mogę zaliczyć mało wydajne (w porównaniu z konkurencją) filtrowanie anizotropowe i trochę słabszą jakość kolorów.

W zasadzie trudno wiążąco opiniować Prolinka, bo brak jest wystarczających danych. Chodzi głównie o docelową zawartość pudełka i co ważniejsze cenę. Moim zdaniem Prolink powinien klasycznie dla siebie uderzyć rynek za pomocą nieco niższej ceny, za którą zaoferuję przyzwoitą jakość, ale bez jakichkolwiek ekstrawagancji w postaci odstępstw od karty referencyjnej czy zbędnych dodatków. Testowana karta odznaczała się solidnością wykonania, stabilnością, oraz przyzwoitą jakością obrazu. Nie znalazłem ewidentnie słabych punktów. Zdecydowanie nie należy się bać zakupu. Jedynie, o czym warto pamiętać to istnienie konkurencji, która również może się zdecydować na okrojenie ceny i zaoferować bardziej optymalny produkt. Przekonamy się o tym niebawem.

Gainward zdecydowanie podąża w innym kierunku. Bogaty zestaw za nieco wyższą cenę. Myślę, że jest to właściwe posunięcie w przypadku kart z tego przedziału cenowego. Dodanie okularów 3D, karty FireWire, radiatorów czy selekcja najdroższych pamięci na rynku w przypadku kart tańszych niż 1000 zł jest trudna w odbiorze, bo różnica cen zwróci uwagę klienta w kierunku droższych modeli samych kart. W przypadku GF4Ti 4600 trudno pisać o możliwościach kupienia w tej cenie czegoś wydajniejszego kosztem np. dodatków. Po prostu nie ma mocniejszych kart. Do tego koszt dodatków stanowi niewielki w sumie procent ceny całości. Płacąc ponad 2000 zł chcemy czegoś ekstra. I Gainward nam to daje. Wysoka jakość, bogactwo konfiguracyjne (2x DVI z przejściówkami), oprogramowanie dodatkowe (pakiet multimedialny i gra), capture zarówno analogowy jak i cyfrowy (FireWire), obszerna polska instrukcja. To wszystko za równie wysoką cenę. Płacisz, wymagasz i co najważniejsze: dostajesz. Jeśli faktycznie producent nie ma nic przeciwko taktowaniu pamięci na poziomie 750MHz (może da się jeszcze wycisnąć "kilka" MHz) to pewnie będzie to również leader wszelkich rankingów benchmarkowych. Myślę, że to wymarzona (niekoniecznie osiągalna finansowo) karta dla większości entuzjastów.

Podsumowując pozostaje mieć nadzieję, że odpowiedź konkurencji, która pewnie za jakiś czas przedstawi coś nowego będzie na tyle silna, że zmusi nVidia do obniżek cen a tym samym produkt w przyszłości będzie dostępny dla szerszego grona odbiorców.

Zobacz także inne artykuły:

Sprzęt do testów dostarczyła firma: Sprzęt do testów dostarczyła firma:

|

|

|

Multimedia Vision

|

|

|

ACTION 2

- 30-418 Kraków ul. Zakopiańska 9

- Tel. (012) 269-07-05 (8 linii w PBX)

- Fax. (012) 266-69-40

- WWW: www.a.pl

- e-mail: office@a.pl

|

|

|

Sklep Internetowy Sirius Computers

|

|

|

|

|

|

|

|

|

|

|

K O M E N T A R Z E |

|

| |

|

- Będe 1 szy :) (autor: sew123 | data: 3/04/02 | godz.: 03:41)

:))

A co do testu to jest OK!!

Szkoda ze ten GF4 4200 to pewnie sie nie ukaże :(Ale może sie myle?? No i szkoda ze Kris nie dal dla porownania na tym samym sprzecie jakiegos GF3 Ti200 lub Ti500.

Ciekawe jest czy NVidia sterownikami wycisnie jeszcze te pare lub parenascie fpsow z tej kości?? W koncu nieraz już nas zadziwiali :)

Swoja drogą i tak żadnego Prolinka juz nie kupie :)))

- sew123 ... będę 2-gi? :-) (autor: Kris-Redakcja | data: 3/04/02 | godz.: 08:10)

Dlaczego 4200 miałby się nie ukazać? nVidia już zakończyła produkcję GF3. IMHO jest jeszcze trochę do "wyciśnięcia" na sterach. Szczególnie w XP. Z Gf3-kami porównanie oczywiście będzie. Nie za dużo na raz. Lancer IMHO już coś pichci :-)

- ano kto wie (autor: Lancer-Redakcja | data: 3/04/02 | godz.: 09:12)

Cos tam sie juz gotuje, jeno przyprawic trzeba :)

- Co kupić? (autor: XepeR | data: 3/04/02 | godz.: 09:25)

Chcialem kupić G3Ti200, ale teraz to juz nic nie wiem... :) Chyba poczekam na G4Ti4200

- a ja tak wymyslilem (autor: Meteor | data: 3/04/02 | godz.: 11:14)

ze wszystko byloby ok, gdyby GF4 byl tak naprawde pierwszym tytpem z lini GF3 i nie mial tej nazwy tylko zupelnie inna. Zastapilby wtedy GF (czyli pierwszy GF i GF2, ktory nie mialby tej nazwy, tylko np. GF PRO, albo cos takiego). Wszyscy bylibysmy wtedy happy, dostalibysmy produkt o niesamowitych mozliwosciach (poprawione wszystko w stosunku do GF2), niesamowitej wydajnoscil, dopracowany.... eh marzenia... ale coz, swiat jest taki jaki jest, premiery musza byc co pol roku, zanim karta doczeka sie dopracowanych sterownikow to zastepuja ja juz inna z dwoma lub trzema malymi ulepszeniami. Niestety to jest tendencja nie tylko w tym przemysle....

- Nazewnictwo ... (autor: Kris-Redakcja | data: 3/04/02 | godz.: 11:23)

Dla mnie koszmar z nazwami ma stałą tendencję rosnącą. Mnogość producentów wywołuje różne mutacje polegające na taktowaniu i pamięciach. IMHO powinno być tylko np. GF4MX i GF4TI (i dodatki np. SDR, DDR, 128MB, 64MB i ew. taktowanie). Przecież nic nie determinuje fizycznych ustawień. Wynalazki z nazwą Pro/Ultra/Hiper itd. są dla mnie ogłupiającym działaniem marketingowym i niech sobie je tylko wprowadza konkretny producent aby odróżnić własne karty ...

- Nazewnictwo ... (autor: Kris-Redakcja | data: 3/04/02 | godz.: 11:23)

Dla mnie koszmar z nazwami ma stałą tendencję rosnącą. Mnogość producentów wywołuje różne mutacje polegające na taktowaniu i pamięciach. IMHO powinno być tylko np. GF4MX i GF4TI (i dodatki np. SDR, DDR, 128MB, 64MB i ew. taktowanie). Przecież nic nie determinuje fizycznych ustawień. Wynalazki z nazwą Pro/Ultra/Hiper itd. są dla mnie ogłupiającym działaniem marketingowym i niech sobie je tylko wprowadza konkretny producent aby odróżnić własne karty ...

- Oo :))) (autor: Lisek | data: 3/04/02 | godz.: 11:51)

Recenzja prawie tak dobra, jak te moje :P

- bdbo (autor: Budasty | data: 3/04/02 | godz.: 12:55)

bardzo dobra obiektywna rezenzja.

- w sumie spoko (autor: Hitman | data: 3/04/02 | godz.: 14:53)

nie jestem jednak przekonany czy w przypadku wyjscia TV sprawe zalatwily nowsze stery tylko. Jakosc bowiem jest zdecydowanie lepsza na TV niz w poprzednich modelach.

- w sumie spoko (autor: Hitman | data: 3/04/02 | godz.: 14:53)

nie jestem jednak przekonany czy w przypadku wyjscia TV sprawe zalatwily nowsze stery tylko. Jakosc bowiem jest zdecydowanie lepsza na TV niz w poprzednich modelach.

- w sumie spoko (autor: Hitman | data: 3/04/02 | godz.: 14:53)

nie jestem jednak przekonany czy w przypadku wyjscia TV sprawe zalatwily nowsze stery tylko. Jakosc bowiem jest zdecydowanie lepsza na TV niz w poprzednich modelach.

- Hitman ... (autor: Kris-Redakcja | data: 3/04/02 | godz.: 14:55)

Nigdy nie pisałem, że jakość wyjścia tv to stery. Zawsze była ona zależna od sprzętu. Pisałem o sterach w kwestii wejścia (capture) ...

- iDCT (autor: GCW-brak rejestracji | data: 3/04/02 | godz.: 19:13)

Myślałem, że iDCT ma tylko seria GF 4 MX. W innych recenzjach nikt nie wspomina o iDCT w GF 4.

- oba maja (autor: Meteor | data: 3/04/02 | godz.: 21:40)

idct

- 600zł ani grosz więcej (autor: cyc-brak rejestracji | data: 3/04/02 | godz.: 21:51)

Ciekawe w jakiej cenie, będzie ten

geforce4Ti 4200. Jak więcej niż 600 zł,to

podziękuję.

- GCW ... (autor: Kris-Redakcja | data: 3/04/02 | godz.: 23:35)

Oczywiście. że nie mają. Dobrze myślałeś ...

- Odradzam ASUS GEFORCE 4 !!!!!!!!!!!!! (autor: odradzam GEFORCE 4-brak rejestracji | data: 4/04/02 | godz.: 00:35)

Krotko powiem ze wiele kart widzialem

geforce 2,3, i teraz 4 mx i 4 ti.

Jako maniak PC Grania jestem wrazliwy na jakosc obrazu no i speed...

Wziolem z pracy na probe nowa karte

ASUS GEFORCE 4 Ti 4400 v8440 128 ddr...

Super karta o wspanialym wygladzie jasne ..

Po zalonczeniu zadnych problemow...i ta szybkosc !!!Na starym V7100 MX w mad. 2002

mialem 2500 teraz 7600!!!

Ale jeden jedyny problem jest!

Kolory w czasie grania sa do niczego!!!

Sprawdzie sami...takie mdle!!!.

Zaden program ustawienia niepomogly....

Postanowilem poczekac na

Best of BEST-

ELSA GEFORCE 4 ti 927

niema szans ELSA ma najlesze kolory jakie widzialem!!

Lukasz

- Za 4-5 miesiecy (autor: speed-brak rejestracji | data: 4/04/02 | godz.: 00:49)

wyjda stery ktore podniosa wydajnosc GF4 o okolo 10-15% (jak to juz mialo miejsce ) .bo na horyzacie bedzie nowy Radeon , a jesienia okolo pozdziernika doczekamy sie nowego (tak naprawde nowego ukladu NV30 ) . Zreszta kolko musi sie krecic czy chcemy czy nie chcemy . Ci ktorym udalo sie kupic GF3 to bez problemow bedo sie cieszyc ta karto minimum przez 1-2 lata . a jak cena GF4 4600 spadnie do 600-800zl to znow bedzie czas na upgrade.

Co do jakosci wyjscia TV to jezeli ma sie TV okolo 21 cali to wyglada nie zle ale ja na 36 calach moge powiedziec ze jest "kicha" i to az na 16 roznych kartach . moze z czasem doczekamy sie ze wyjscie TV bedzie jakosci DVD .

Wyniki Kris ma troche kiepskie biorac pod uwage cena sprzetu . Na amd i to bez krecenia czego kolwiek i sztuczek mozna mies lekko 11000 w 3DMark 2001SE . a i w grach tez troche lepiej ale czy warto o tym mowic jak dotyczy to 2-3 fps?? chyba nie.Lepiej miec stabulny system jak co godzine resetowac:)))).

Jedynie co mnie drazni to to ze test po tak dlugim czasie od premiery robiony jest na nie produkcyjnych modelach .

Moj Visiontek (przed produkcyjny 4600model) kreci sie 354/765 !!!! ale produkcyjny tylko na 322/705!!! dlatego dopiero nopisalem cos o GF4 jak moglem porownac to co mozna kupic w sklepie .

- Co wybrac ATI?GE 3? (autor: ATI8500-Geforce 3 ?-brak rejestracji | data: 4/04/02 | godz.: 00:57)

A wiec postanowilem wziasc

Ati 8500 le o Geforca 3 ti 200

Czy ktos ma zdanje co jest lepsze???

- ATI czy GF3 ?? (autor: speed-brak rejestracji | data: 4/04/02 | godz.: 01:48)

Jezeli duzo grasz to GF jezeli malo , a wiecej czasu spedzasz na necie i innych aplikacjach to ATI. Porownam to do GF3 i Radeona 8500(orginal ) to wole grac w cokolwiek na GF ale pozatym to wole Radeona. Mam nadizeje ze ci to pomoze.

- iDCT (autor: GCW-brak rejestracji | data: 4/04/02 | godz.: 11:32)

Kris. W takim razie popraw pierwszą tabelkę.

- GCW ... (autor: Kris-Redakcja | data: 4/04/02 | godz.: 11:41)

Już wczoraj o to prosiłem Michała ...

- ASUS? (autor: Remedy-brak rejestracji | data: 4/04/02 | godz.: 11:56)

Ktoś napisał, że odradza ASUSa ze względu na kolory w grach. Człowieku idż do okulisty. Po pierwsze zrób testy Quality (chodzi o obraz) w różnych benchmarkach i porównaj z oryginałem. Po drugie niedawno widziałem na którymś z zachodnich (renomowanych) serwisów (nazwy nie pamietam :() porównanie ASUSa i Gainwarda na GF4Ti4600 i ASUS okazal się lepszy pod każdym względem, także jakość obrazu i kolorów była lepsza!!!!!!!!!!!!! ASUS jest najlepszy i najszybszy :)))

- Remedy (autor: Meteor | data: 4/04/02 | godz.: 12:53)

a swistak zawija w sreberka. Ty widziales recenzje kolega mial ja w lapach i na monitorze. Moze mial slaby egzemplarz, moze ma slaby monitor. Nie trzeba od razu najezdzac na siebie.

- FUCK ELSA & ASUS (autor: szakal-brak rejestracji | data: 4/04/02 | godz.: 14:34)

nie owjac w bawełne GF4Ti t naprawde marketingwy GF3 Ultra SUPER PRO MAXX :)))

- Kris (autor: Młody-brak rejestracji | data: 5/04/02 | godz.: 01:50)

Mam pytanie czy w testach MOH miałeś zwykłą wersję gry czy dodatkowo jakiś patch.

- Młody ... (autor: Kris-Redakcja | data: 5/04/02 | godz.: 08:37)

v1.1. Nie ma to jednak znaczenia bo chodzi o porówananie na tej samej wersje różnych kart a nie optymalizowanie samej gry. W zasadzie im bardziej "skopana" wersja tym lepiej dla porównań bo karty muszą się borykać z większym problemem ...

- Vertex Shadery (autor: Pet-brak rejestracji | data: 5/04/02 | godz.: 20:34)

Radeon 8500 ma dwa Vertex Shadery a nie jeden jak w 1 tabelce.

- Pet ... (autor: Kris-Redakcja | data: 5/04/02 | godz.: 21:43)

A masz info ATI potwierdzające ten fakt? Ja nie znalazłem (tylko bez odwołań do Tech-Report) ...

- ... (autor: Pet-brak rejestracji | data: 6/04/02 | godz.: 15:09)

Nie lubimy Tech-Report ? Czy dlatego, ze u nich wyszlo, iz R8500 ma szybsze Vertex Shadery od Ti4600 ?

http://www.tech-report.com/...nvidia/index.x?pg=12

Oficjalnie znalazlem tylko tego PDFa:

http://www.ati.com/...hardware/pdf/smartshader.pdf

4 strona. Widac 2 potoki dla strumieni vertexow. Ale wynika z tego, ze tylko 1 w pelni programowalny a 2gi robi T&L takie jak w DX7 co i tak zawsze sie robi.

I jeszcze to co napisal gosciu z ATI:

The 8500 can complete 2x the vertex shader instructions/clock cycle that a GF3 can complete due to the extra vertex engine in the 8500. The XBox's vertex engine should therefore be on par with the 8500. This is why the 8500 stomps the GF3 in synthetic vertex tests.

__________________

Chris Brennan

ATI Research

na tym forum:

http://www.rage3d.com/...hlight=dual+vertex+shader

Na prawde nie da sie sprawdzic co naprawde jest w srodku bez dostepu do dokumentacji technicznej gpu. Najwazniejsza jest wydajnosc a tu widac, ze zarowno GF4Ti jak i R8500 musza miec po 2 potoki bo vertex shadery na obu kartach maja bardzo zblizona wydajanosc. Zauwaz jak GF4 jest wolniejszy od R8500 skoro ma miec taki sam Vertex Shader ?

- ... (autor: Pet/BB-brak rejestracji | data: 6/04/02 | godz.: 15:11)

I sie walnalem w ostatnim zdaniu. Ofcoz GF3 jest wolniejszy w vertexach od R8500 a nie GF4 :)

- Wydajność (autor: fl@sz-brak rejestracji | data: 7/04/02 | godz.: 18:09)

Pytanie trochę z innej beczki.Chciałem spytać o wydajność chipsetów tzn.testowałeś sprzęt na płycie z via kt266 a ja mam płytę na amd761(abit kg7Lite),pytanie czy na podobnym sprzęcie ale na innym chipsecie(amd 761)wyniki są do siebie zbliżone?

- Kris (autor: Młody-brak rejestracji | data: 7/04/02 | godz.: 23:00)

Mam jeszcze jedno pytanie: jak ogólnie chodzi Medal of Honor na GF4, pytam dlatego że mam w domu AMD XP1700+, GF4 Ti 4400 i gra mi cholernie zwalnia już w pierwszym etapie(momentami poniżej 15 FPS)(detale na ful 800x600). Próbowałem już sterowniki 2750, 2770, 2823, a także WIN98, ME, XP i zawsze to samo!

- Pet ... (autor: Kris-Redakcja | data: 8/04/02 | godz.: 00:12)

Oczywiście, że R8500 zdecydowanie wydajniej liczy wierzchołki niż GF3. Sądzę, że głównie dla np. 3DMarka dodali 2-gi vertex w GF4 bo mimo wyższego taktowania nie sprostałby ATI. Oficjalnie Radek ma vertex fixed-hardware i drugi programowalny (niekoniecznie potrafią pracować razem). Nic poza tym. Tech-Report pisze ciekawe artykuły ale nie można się na nie powoływać bo w wielu przypadkach są w sprzeczności z oficjalnymi danymi producenta (dlatego pytałem o konkret) ...

- Młody ... (autor: Kris-Redakcja | data: 8/04/02 | godz.: 00:14)

Nie przeszedłem całej gry na GF4 ale zachowywał się (oprócz tego lasku) tak samo dobrze jak i inne karty. Nie wiem skąd te 15 fps ... może włączyłeś jakiś efekt (fsaa czy anizo)?

- Kris (autor: Młody-brak rejestracji | data: 8/04/02 | godz.: 14:33)

Najlepsze jest to że jak włącze AA4x Af8x to ta gra chodzi dokładnie tak samo, nie ma wogóle spadku prędkości. Kombinowałem już z wszystkim, zawsze to samo. Może mam jakąś zrypaną wersję nie wiem.

- Kris (autor: Młody-brak rejestracji | data: 8/04/02 | godz.: 14:37)

Jeszce jedno np: w RTC Wolfenstein(checkpoint) 1024x768 mam tylko 84 fps, to chyba też za mało? A jest możliwość że to karta będzie zrypana? Choć w 3D mark 2001 ma 9609.

- Młody ... (autor: Kris-Redakcja | data: 8/04/02 | godz.: 15:39)

A puszczałeś checkpoint kilka razy pod rząd aby wyeliminować wpływ np. dogrywania z hdd? A wyłączyłeś vsync?

- Kris (autor: Młody-brak rejestracji | data: 8/04/02 | godz.: 15:59)

To z tym HDD jeszcze nie próbowałem. A vsync to wyłączyłem(choć wszyscy mi mówią że to ten vsync). Wyłączyłem go w RIVA TUNER (i w oryginalne zakładce wyłączyłem go dopiero na sterownikach 2770, na innych ta zakładka była nieaktywna) i dalej to samo. Dałem na always off. czy mam wybrać inna funkcję?

- geforce mx 440 winfast z błędami (autor: goofer-brak rejestracji | data: 8/04/02 | godz.: 22:12)

mam gf 440 winfast i niedziala na msi pro2, gf4 sa glupimi kartami i niedpracowanymi, a ich jakosc obrazu

- Goofer ... (autor: Kris-Redakcja | data: 9/04/02 | godz.: 00:36)

Czytałem o jakiejś petycji do MSI aby przynajmniej ich własne karty chodziły z ich własnymi płytami :-)

- MSI GeForce 4 mx 440 (autor: L0neW0lf-brak rejestracji | data: 12/04/02 | godz.: 00:43)

Ludzie Swieci! wystrzegajcie sie MSI kart ,jakosc obrazu w 2D TO KATASTROFA 1152x864 i rozmyte trzcionki! nie mowiac o kolorach na mojej ATI 2MB mam o 40% lepsza ostrosc! Przy MSI karcie musialem okulary korygujace zalozyc zeby cos widziec.

Kompatybilnosc(MSI nie posiada takiego slowa w swoim slowniku{a moze uwazaja to za zbedne?)}

Reasumujac MSI stworzylo ATRAPE a nie karte graficzna(hmm... moze to miala byc karta muzyczna no nie wiem)

Pozdroofka

P.S

A Tych inzynierow z MSI powinno sie wykastrowac za kare!

- MSI GeForce 4MX 440 (autor: NoVa-brak rejestracji | data: 12/04/02 | godz.: 01:10)

Amen.

- APROPO Medal of Honor (autor: DZIUBEK-brak rejestracji | data: 22/04/02 | godz.: 23:50)

Piszecie o tych wypasionych kartach, a mi ślinka cieknie:).Przeżyłem tylko szok jak Młody napisał że ma 15 fps w MOH.Ja mam leciwego GF mx(win fast,215mhz,220mhz),A 1.4GHz,płyta hhhmm..ECS KT 266 i w lesie: na max wszystkie detale, w 32 bitach 1024x768,śmiga jak złoto,czasem przytnie,ale w 800x600 nawet nie przycina,chodzi płynnie,nie wiem ile moge mieć klatek bo nie wiem jak sprawdzić:(

Może mam dodry egzemplaż MX he he..

A bym zapomniał świetne porównanie.

- GF4 750 (autor: Diablos-brak rejestracji | data: 16/05/02 | godz.: 11:55)

Tak się składa że zakupiłem ostatnio model GF4 750 gaiwarda i granie nabrało nowego wymiaru!!!

Nic się nie haczy nie ma prawa jest tylko jedno ale..

Karta chodzi stabilnie tylko pod XP przy instalowaniu na inny windows i zrobieniu testów D3D wyskakuje jakiś błąd i karta działa tylko pod openGL programy nie wykrywaja akceleracji 3d...

- dupa (autor: dupak-brak rejestracji | data: 20/05/02 | godz.: 12:25)

dupa mi scierpla od siedzenia i czytania tych fantazji erotycznych o tych kartach

- twin view (autor: Ciemniak-brak rejestracji | data: 23/05/02 | godz.: 09:59)

Proszę o pomoc.. Która TANIA lub BARDZO TANIA z kart z TV-OUT dostepnych na rynku pozwala na TwinView uzykać jednocześnie obraz na monitorze i telewizorze.

Słyszałem że te nowsze to pozwalają tylko na jednym urządzeniu w tym samym czasie - to prawda?

Proszę o pomoc na @

Z góry dzięki....

- Twin View (autor: Ciemniak-brak rejestracji | data: 23/05/02 | godz.: 10:05)

uzupełniam

dzięki

- Geforce 4 (autor: Havoc-brak rejestracji | data: 7/06/02 | godz.: 10:41)

Czadowo , chyba se kupie !!!!!!

|

|

|

|

|

|

|

|

|

D O D A J K O M E N T A R Z |

|

| |

|

Aby dodawać komentarze, należy się wpierw zarejestrować, ewentualnie jeśli posiadasz już swoje konto, należy się zalogować.

|

|

|

|

|

All rights reserved ® Copyright and Design 2001-2025, TwojePC.PL |

|

|

|