|

TwojePC.pl © 2001 - 2025

|

|

RECENZJE | Radeon 9800 Pro vs GeForceFX 5900 |

|

| |

|

Radeon 9800 Pro vs GeForceFX 5900

Autor: Kris | Data: 10/07/03

|

Dziś chciałbym zaproponować pojedynek na szczycie klasyfikacji zarówno wydajnościowej jak i cenowej. Dzięki uprzejmości firm ABCData oraz MSI Polska przedstawię porównanie najsilniejszych, dostępnych obecnie na naszym rynku kart graficznych przeznaczonych do gier. Będą to Radeon 9800 Pro oraz GeForceFX 5900. Obie karty kosztują ok. 2000 zł i naturalnym wydaje się fakt, że konfrontacja jest nieunikniona. Tłem do porównań będą poprzednicy dzisiejszych bohaterów w postaci Radeona 9700 Pro oraz GeForceFX 5800 Ultra. Podstawowym wyznacznikiem badanych kart jest wydajność generowania grafiki trójwymiarowej i skoncentruję się właśnie na tym zagadnieniu. W recenzji postanowiłem tym razem zawrzeć nieco więcej informacji o samej zasadzie doboru testów wydajności. Mam również nadzieję, że uda mi się napisać, dlaczego porównanie nowych kart ATI i nVidia nie jest zadaniem łatwym dla testującego. Mało odpornych od razu przestrzegam, że będą ględził. Czasem nawet ponad granicę przyzwoitości. Zapraszam. Dziś chciałbym zaproponować pojedynek na szczycie klasyfikacji zarówno wydajnościowej jak i cenowej. Dzięki uprzejmości firm ABCData oraz MSI Polska przedstawię porównanie najsilniejszych, dostępnych obecnie na naszym rynku kart graficznych przeznaczonych do gier. Będą to Radeon 9800 Pro oraz GeForceFX 5900. Obie karty kosztują ok. 2000 zł i naturalnym wydaje się fakt, że konfrontacja jest nieunikniona. Tłem do porównań będą poprzednicy dzisiejszych bohaterów w postaci Radeona 9700 Pro oraz GeForceFX 5800 Ultra. Podstawowym wyznacznikiem badanych kart jest wydajność generowania grafiki trójwymiarowej i skoncentruję się właśnie na tym zagadnieniu. W recenzji postanowiłem tym razem zawrzeć nieco więcej informacji o samej zasadzie doboru testów wydajności. Mam również nadzieję, że uda mi się napisać, dlaczego porównanie nowych kart ATI i nVidia nie jest zadaniem łatwym dla testującego. Mało odpornych od razu przestrzegam, że będą ględził. Czasem nawet ponad granicę przyzwoitości. Zapraszam. | |

|

Ewolucja

ATI Radeon 9700 Pro, który pojawił się w zeszłym roku był niewątpliwie nową jakością zarówno pod względem wydajności jak i możliwości graficznych. Niemal pół roku zajęło firmie nVidia wypuszczenie karty tej samej generacji i co ważniejsze jej przyjęcie przez rynek było na tyle chłodne, że niemal natychmiast ruszyły prace nad jego następcą. Tym nie mniej, dzięki zastosowaniu najnowszej generacji pamięci oraz kosmicznego wręcz chłodzenia GFFX 5800 Ultra w większości testów uzyskał niewielką przewagę wydajnościową nad konkurencją, co skłoniło ATI do odświeżenia oferty w topowym segmencie. Tak oto pojawił się nowy lider wśród Radeonów oznaczony symbolem 9800 Pro. Układ spełnił swoje zadanie w kwestii dominacji nad rywalem z obozu nVidia, ale sielanka nie potrwała długo. Dwa miesiące później do sprzedaży trafia GeForceFX 5900 rozpoczynając nową bitwę o rynek. Jego wejście poprzedza typowa akcja marketingowa mająca ugruntować wśród potencjalnych nabywców przeświadczenie, że nowa karta wręcz zadepcze konkurencję. Jednocześnie nVidia odcina się całkowicie od jego poprzednika, przyznając do błędu koncepcji konstrukcyjnej. Karty 5800 Ultra znikły z materiałów reklamowych firmy jak kamfora. Po prostu zastały całkowicie zastąpione.

Na rozgrzewkę tabelka parametrów podstawowych oraz wydajności teoretycznej:

Zmienna ilość strumieni renderowania i co za tym idzie Fill Rate GeForceFX związana jest z działaniem samego układu, który zachowuje się różnie, w zależności od realizowanych zadań. Nic w tym względzie nie zmieniono w stosunku do poprzednika. W związku z tym, że nVidia nie zdradza części tajemnic związanych z architekturą swoich najnowszych kart to niektóre dane mają charakter nieoficjalny.

Zanim zacznę rozwijać kwestię różnic warto wyjaśnić moje podejście do odmian modeli. Tabela zawiera specyfikację testowanych przeze mnie kart i wszystko wskazuje na to, że są to bazowe odmiany, najlepiej reprezentujące możliwości nowych produktów. Zarówno ATI jak i nVidia przewidziała również prestiżowe mutacje, które przy znaczącej różnicy w cenie osiągają niewiele większą wydajność. Prawdopodobnie ich dostępność będzie bardzo ograniczona. Są to odmiany posiadające 256MB pamięci. W przypadku nVidia modele takie noszą nazwę Ultra i oprócz ilości RAM będą miały również nieco wyżej taktowany rdzeń 450MHz. W ATI nazwa się nie zmienia natomiast zamiast 128MB pamięci DDR-1 340MHz zastosowano 256MB DDR-2 350MHz. W obydwu przypadkach nie należy spodziewać się jakichkolwiek spektakularnych różnic wydajności w związku z tym, że tak duża ilość pamięci nie jest potrzebna, aby gry osiągały pełnię swoich możliwości. Co najwyżej można liczyć na kilka fps testowych więcej (głównie dzięki nieco wyższym zegarom). Szczególnie w wysokich trybach FSAA i rozdzielczościach rzędu 1600x1200x32. Jak dla mnie przerost marketingu nad produktem. Warto jednak wiedzieć, czym one się różnią i nie dać się handlowcom wciskającym dobrze brzmiące nazwy Ultra, DDR-2 czy hasło 256MB. Zysk minimalny a portfel cieńszy o ponad 500 zł. O tym, że są to niewygodne landary lub ponadprzeciętne grzałki nawet nie wspomnę.

Zacznę od Radeona. Różnice sprzętowe pomiędzy układami R300 a R350 moim zdaniem można sprowadzić do czterech podstawowych punktów:

- Wyższe taktowanie: Pierwszą rzeczą, jaka rzuca się w oczy jest zwiększenie częstotliwości pracy zarówno rdzenia jak i pamięci. Zmiany te możliwe były dzięki dodatkowej optymalizacji struktury układu, drobnej modyfikacji kontrolera pamięci, polepszeniu chłodzenia oraz stabilniejszej konstrukcji płytki. W zasadzie jest to podstawowa i najbardziej spektakularna różnica.

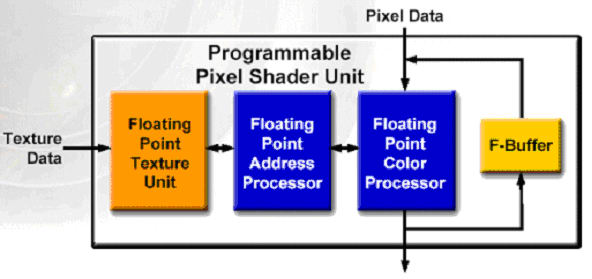

- F-Bufor: Ograniczeniem układu R300 była możliwość wykonywania w jednym przebiegu programów pixel shadera zawierających maksymalnie do 64 instrukcji. Dla porównania NV3x może przetworzyć 1024 instrukcje. Aby zmusić R300 do zobrazowania bardziej skomplikowanych efektów pojedynczy shader musiał być dzielony i wykonywany sekwencyjnie przy wykorzystaniu technik wielo-przebiegowych, co powodowało znaczące straty wydajności wynikające m.in. z niepotrzebnego powtarzania tych samych operacji. W pewnych warunkach prowadziło to również do pogorszenia finalnej jakości renderowanych ramek. W układzie R350 wprowadzono dodatkową jednostkę pomocniczą o nazwie F-Buffer (Fragment Stream FIFO Buffer). Funkcjonalnie jest to rodzaj podręcznej pamięci służącej do przechowywania części pośrednich obliczeń, dzięki której shader może być zasilany partiami instrukcji bez konieczności zapisu i odczytu danych poprzez bufor ramki. Teoretycznie technologia ta umożliwia wykonywanie programów dla shadera o nieograniczonej ilości instrukcji bez strat typowych dla pełnego powtarzania przebiegów przez strumień renderowania. Moim zdaniem ATI chodziło głównie o wyeliminowanie potencjalnego źródła słabości układu R300 w porównaniu z NV3x. Oczywiście pytanie o to czy R350 doczeka gier o tak dużym skomplikowaniu shaderów oraz jak w praktyce będzie wyglądała ta konfrontacja pozostaje bez odpowiedzi.

- Usprawnienie kontrolera pamięci: Jednocześnie ze zwiększeniem taktowana pamięci ATI dokonało modyfikacji samego kontrolera mającej na celu usprawnienie zarządzania szyną w czasie największego natężenia operacji odczytu i zapisu. W założeniach ma to dodatkowo poprawić wydajność, zwłaszcza podczas renderingu wykorzystującego funkcję antyaliasingu. W sumie drobiazg.

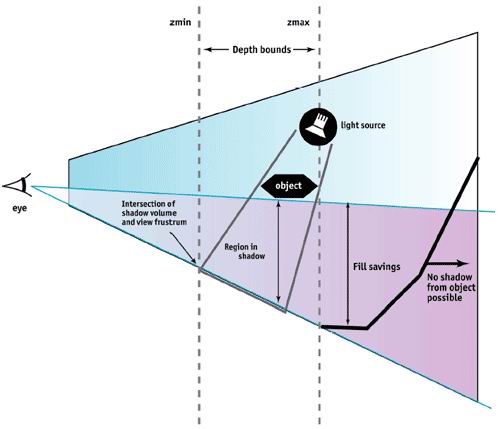

- Usprawnienie działania pamięci podręcznej Z-Bufora: Według ATI ma to pomóc w lepszym wykorzystaniu przez programistów przyszłych gier efektów nakładania cieni. Jako, że sprawa dotyczy konkretnie użycia techniki "stencil shadow volume" to wygląda to na wyraźny ukłon w stronę Carmack'a i jego Doom3 oraz wskazuje na to, co realnie boli R300 w starciu z NV3x.

Oczywiście wraz z nowym układem pojawiły się modyfikacje nazw technologii ATI. Skoro mamy F-Bufor to SMARTSHADER™ podwyższył wersję z 2.0 na 2.1. Optymalizacja cache Z-Bufora spowodowała, że HYPER Z™ III zmienił się w III+. Dodatkowo SMOOTHVISION™, tym razem już tylko dzięki zabiegom czysto programowym uzyskał numerek 2.1. Wszystkie pozostałe technologie, którymi szczycił się Radeon 9700 Pro zostały zaadoptowane bez zmian. Zainteresowani dokładniejszym opisem mogą się z nimi zapoznać w recenzji R9700 Pro.

Teraz kolej na GeForce'a. W podobny sposób potraktuję różnice pomiędzy NV30 a NV35. Podstawowe zmiany zawarłem w punktach:

- Magistrala pamięci: Najważniejszą zmianą, jaka odróżnia nowego FX'a od poprzednika jest przejście na 256-bitową magistralę pamięci. Jest to najbardziej istotny element związany z wydajnością. Analitycy zgodnie twierdzili, że odziedziczony po GF4Ti kontroler był hamulcem dla wysoko taktowanego rdzenia nowych kart. Zdublowanie ilości linii dostępu powoduje dwukrotne zwiększenie teoretycznej przepustowości pamięci. Jak to wygląda w praktyce dowiemy się w dalszej części recenzji.

- Optymalizacja przesyłu danych do lokalnej pamięci: Z konstrukcją nowego kontrolera pamięci, obsługującego magistralę 256-bitową związana jest modyfikacja technik optymalizacji zarządzania transferem. Jest to bardzo istotna kwestia, bo wypełnienie takiej szyny danymi nie jest zadaniem trywialnym i od tego, w jakim stopniu się to powiedzie, teoretyczna przepustowość przełoży się na realną wydajność. Specjalne algorytmy określają, kiedy efektywniej będzie zastosować konkretny typ kompresji lub zmianę parametrów pracy i jakich danych mają one dotyczyć. Poprawione procedury, według zapewnień nVidia, zwiększają prawdopodobieństwo użycia kompresji. Ma to spowodować, że wydajność nie będzie drastycznie spadać w wysokich trybach FSAA. Kwestia na ile zwiększenie wydajności związane jest z poprawieniem algorytmów optymalizacji a na ile z samą magistralą 256-bitową pozostanie pewnie tajemnicą producenta.

- UltraShadow: Usprawnienie obliczeń efektu cieni realizowanych metodą "stencil shadow volume". Kolejny wyraźny ukłon w stronę Doom3. Pozwolę sobie na małą złośliwość. Carmack jeszcze nie wydał swojej słynnej gry a już czołowi producenci układów graficznych dostosowują się do jej wymogów. Ten człowiek ma niespotykaną siłę przebicia. Mam nadzieję, że gra okaże się takim przebojem, na jaki oczekujemy już od dłuższego czasu. UltraShadow to korzyść zarówno dla twórców gier jak i dla nVidia. Programiści dostają bardzo wygodne i efektywne w użyciu narzędzie to tworzenia zaawansowanych efektów cieni a nVidia nie tylko zyskuje na omijaniu obliczeń elementów przesłoniętych, ale tak kieruje ich realizacją, że umożliwia układowi NV35 działanie w ośmiu strumieniach renderowania likwidując tym samym słabość swojej architektury. Jeśli do tego programiści nie zechcą przygotować alternatywnego, optymalizowanego pod inny układ efektu to można przy okazji dać prztyczka konkurencji. Przynajmniej w kwestii tworzenia cieni. NVidia nie ukrywa, że na takiej opcji zależy im najbardziej. Oczywiście dopiero czas pokaże jak postąpi Carmack i czy sprawa dotknie również innych, nowych produkcji gier.

- Zmniejszenie taktowania: Reorganizacja architektury układu oraz chęć zdjęcia z karty suszarki zwanej FlowFX spowodowała konieczność zmniejszenia taktowania rdzenia z 500 na 400MHz. Moim zdaniem jest to znaczący sukces zdrowego rozsądku projektantów nVidia. Może i w pewnych zastosowaniach zmniejszy to wydajność, ale zysk związany z brakiem świdrującego ucho hałasu jest jak dla mnie zdecydowanie ważniejszy. Zmniejszono również częstotliwość pracy pamięci z 500 na 425MHz (DDR-2 zastąpiono DDR-1), co pozwoliło na zastosowanie znacznie tańszych, łatwiej dostępnych oraz co ważne - mniej grzejących się modułów. W związku z tym, że jednocześnie zwiększono szerokość magistrali to i tak przepustowość teoretyczna nowej karty jest 40% wyższa.

Oczywiście zmiany pociągają, podobnie jak u konkurencji modyfikacje nazewnictwa technologii własnych. Dzięki UltraShadow CineFX uzyskał numerek 2.0 a zestaw usprawnień w procesie przesyłania danych dodał do Intellisample słowo HCT (High Compression Technology). Pozostałe technologie zaimportowano od NV30 bez zmian. Ich dokładniejszy opis zainteresowani znajdą w recenzji GFFX5800Ultra. Reszty dzieła dokonują już same sterowniki.

Mam nadzieję, że opisane zmiany rozwieją wątpliwości, co to wprowadzonych przez producentów modyfikacji. Tym razem mamy do czynienia bardziej z ewolucją niż rewolucją w dziedzinie wparcia grafiki trójwymiarowej gier. Obie karty są ulepszeniem wcześniejszych produktów mającym głównie na celu zwiększenie ich wydajności w stopniu pozwalającym na osiągnięcie choćby minimalnej przewagi testowej nad przeciwnikiem. Nikt natomiast nie będzie polemizował z zapewnieniami konstruktorów o zdecydowanie większych możliwościach zanim nie sprawdzi tego w warunkach "bojowych". Zanim to jednak nastąpi chciałbym przedstawić bohaterów dzisiejszej batalii.

|

|

|

|

|

|

|

|

|

|