TEST: BFG NVidia GeForce 7900 GTX

Autor: Kris | Data: 25/04/06

|

Około półtora miesiąca miłośnicy kart GeForce czekali na odpowiedź firmy nVidia, na styczniową premierę ATI. Zaprezentowany wtedy Radeon X1900XTX uznany został przez zdecydowaną większość testujących - najmocniejszą kartą 3D na rynku. 9 marca pojawił się następca zdetronizowanego modelu GeForce 7800GTX, o niewiele różniącym się numerze 7900. Jako, że w przeczytanych recenzjach nie udało mi się znaleźć jednoznacznej odpowiedzi na pytanie, która z nowych kart jest wydajniejsza, to nie pozostało mi nic innego, jak osobiście spróbować bezpośredniego porównania tych dwóch gigantów. Dodatkowym smaczkiem pojedynku będzie wykorzystanie podkręconej wersji GF7900GTX, która w postaci karty BFG wypożyczona została do testów przez firmę eXtremeMem. Konkurencyjnego Radeona X1900XTX zapewniła firma ATI. Do porównań użyłem odświeżonego zestawu testów oraz ekstremalnych trybów, które w założeniach miały za zadanie dociążyć testowane potwory tak, aby framerate wynikał wprost z ich mocy przetwarzania 3D. Zapraszam do recenzji ... Około półtora miesiąca miłośnicy kart GeForce czekali na odpowiedź firmy nVidia, na styczniową premierę ATI. Zaprezentowany wtedy Radeon X1900XTX uznany został przez zdecydowaną większość testujących - najmocniejszą kartą 3D na rynku. 9 marca pojawił się następca zdetronizowanego modelu GeForce 7800GTX, o niewiele różniącym się numerze 7900. Jako, że w przeczytanych recenzjach nie udało mi się znaleźć jednoznacznej odpowiedzi na pytanie, która z nowych kart jest wydajniejsza, to nie pozostało mi nic innego, jak osobiście spróbować bezpośredniego porównania tych dwóch gigantów. Dodatkowym smaczkiem pojedynku będzie wykorzystanie podkręconej wersji GF7900GTX, która w postaci karty BFG wypożyczona została do testów przez firmę eXtremeMem. Konkurencyjnego Radeona X1900XTX zapewniła firma ATI. Do porównań użyłem odświeżonego zestawu testów oraz ekstremalnych trybów, które w założeniach miały za zadanie dociążyć testowane potwory tak, aby framerate wynikał wprost z ich mocy przetwarzania 3D. Zapraszam do recenzji ... | |

|

Wprowadzenie

Sercem GeForce 7900GTX jest układ nVidia o nazwie kodowej G71. Jest to pierwszy dedykowany GPU tego producenta wykorzystujący technologię krzemową 90nm, taką samą, jaką w zeszłym roku skutecznie wdrożyła firma ATI. W związku z tym, że praktycznie nie zmienił się zestaw możliwości w zakresie generowania efektów 3D, to można w uproszczeniu stwierdzić, że G71 jest niczym innym, jak G70 wykonanym w 90um. Bezsprzecznymi zaletami takiego posunięcia są możliwości uzyskania wyższego taktowania lub zmniejszenie poboru mocy przy jednoczesnym obniżeniu kosztów wytwarzania układu (z jednego „wafla” krzemowego da się wyciąć większą ilość chipów).

W stosunku do ekstremalnej wersji GF7800GTX nastąpiło podniesienie taktowania rdzenia o konkretną wartość 100MHz. Układ graficzny nowej karty nVidia ma więc to samo taktowanie, co konkurencyjny Radeon X1900XTX. Tym razem jednak wzrost częstotliwości pracy nie skonsumował zysku „energetycznego”, bo niespodziewanie okazuje się, że nowy GeForce pobiera ok. 20W mniej od swojego poprzednika i jednocześnie ok. 40W mniej od najmocniejszego Radeona. Wartości te potwierdziłem za pomocą własnoręcznych testów. Skąd ta różnica? Największą zagadką G71 jest zmniejszenie, w stosunku do G70, liczby tranzystorów budujących układ graficzny, z 302 do 278 mln. Jeśli porównamy to z ATI R580 i monstrualną liczbą 384 mln, to sama kwestia mniejszego poboru mocy przy tym samym taktowaniu wydaje się oczywista. Pewien dodatkowy wpływ na energooszczędność ma również obniżenie taktowania pamięci o 50MHz, najprawdopodobniej związane ze zmniejszeniem ich napięcia zasilania. Jak to jednak możliwe, że układ zachowuje pełną funkcjonalność poprzednika po wycięciu 25 mln tranzystorów? Ba. Mało tego. W stosunku do poprzednika wprowadzono do niego dwa układy do transmisji DVI oparte na standardzie Dual-Link (obsługa cyfrowych matryc do 2560x1600), które naturalnie też musiały „kosztować” pewną liczbę tranzystorów. Sądzę, że odpowiedzi na to pytanie należy szukać w G70. Najbardziej prawdopodobnym wyjaśnieniem tego zjawiska jest możliwość „ukrycia” w jego strukturze większej ilości modułów przetwarzania, niż wynikałoby to z jego specyfikacji. Trudno powiedzieć czy są to mityczne 32 „potoki”, o których istnieniu wcześniej donosiły plotki, a które ze względów technicznych musiały zostać zablokowane, czy też są to inne elementy funkcjonalne, które z ważkich powodów nie mogły zostać uruchomione w GF7800GTX. W każdym razie, jak dla mnie po prostu pozbawiono G70 jakiegoś „balastu”.

Karty GeForce 7900GTX praktycznie nie różnią się od testowanej wcześniej, specjalnej wersji 7800GTX, wyposażonej w 512MB pamięci lokalnej. Wprawdzie karta ta stanowi odnośnik porównawczy dla nowych produktów nVidia ale przypominam, że jest to ekstremalnie podkręcona wersja „klasycznego” G70 (430/600MHz). Produkt ten w zasadzie nigdy nie był sprzedawany w masowych ilościach. Nieliczne egzemplarze pojawiały się w ofertach sklepów w cenie wręcz zaporowej, natomiast spotkać je można było głównie w recenzjach (egzemplarze testowe były dostępne dla recenzentów w przedstawicielstwach nVidia), gdzie odsłużyły dzielnie jako pogromca RX1800XTX. Po pojawieniu się GF7900GTX znikły z cenników utwierdzając mnie w przekonaniu, że był to produkt głównie marketingowy i nie ukrywam, że dobrze przysłużył się handlowcom producenta. Testowany dziś GeForce 7900GTX jest bez wątpienia „prawdziwym” produktem i choć ostatnio wyraźnie nVidia ma pewne problemy z dostarczeniem na rynek odpowiedniej ilości układów, to nic nie wskazuje na to, że zainteresowany kupnem miłośnik gier miałby realny problem z jego nabyciem. Aktualnie, wyposażone w 512MB pamięci karty GF7900GTX dostępne są w cenie od ok. 2100 zł. Podobnie zresztą jak ich podstawowy konkurent ze stajni ATI czyli Radeon X1900XTX.

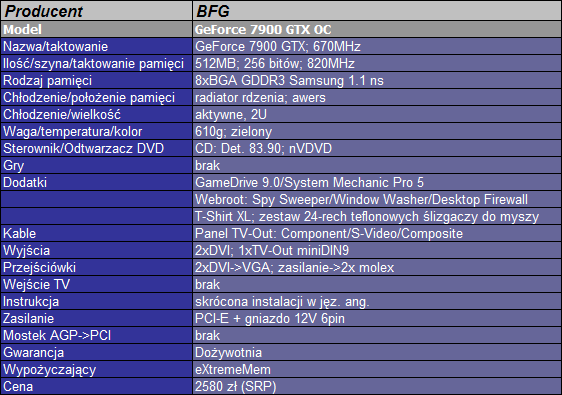

BFG GeForce 7900GTX OC 512DDR3 256bit PCI-E TV/2xDVI

Dzięki uprzejmości firmy eXtremeMem, importera kart BFG Technologies, po raz pierwszy miałem możliwość testowania karty graficznej od tego producenta. Dotychczas produkty BFG znane były głównie za oceanem, gdzie szacunek klientów wypracowały dzięki dobrym warunkom gwarancyjnym oraz rozbudowanemu wsparciu technicznemu. Poza supportem głównym magnesem przyciągającym rzesze graczy jest wyższe od referencyjnego taktowanie kart BFG, co odzwierciedlone jest w nazwach wszystkich modeli dodatkowym określeniem „OC” (overclocking). Sądzę, że na naszym rynku karty te będą walczyły o klienta głównie z Gainwardem, ze względu na zbliżony profil produktów. W związku z tym, że w takim wypadku sukces rynkowy zależy nie tylko od ceny i dostępności, ale i kwestii związanych z suportem, to oczywiście trudno przewidzieć, jaką popularność osiągnie BFG Technologies na naszym rynku. Sieć dystrybucyjna jest dopiero w budowie. Od importera uzyskałem informację, że podobnie jak na amerykańskim rynku karty objęte są dożywotnią gwarancją świadczoną w Polsce, przez firmę eXtemeMem. W stosunku do aktualnie sprzedawanych produktów stosowana będzie zasada wymiany uszkodzonej karty na nową. Karty trafiły już do sprzedaży, a przedstawiciel eXtremeMem wskazał sklep wysyłkowy Sirius jako możliwe miejsce dokonania zakupu. Aby uzyskać konkretniejsze informacje sugerowałbym bezpośredni kontakt z dystrybutorem. Czas przedstawić bohatera recenzji.

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

BFG Geforce 7900GTX OC 512MB przybył w postaci, jaka dostępna jest w sklepach. W dużym pudełku oprócz karty „właściwej”, okablowania i oprogramowania dołączono dwa nietypowe dodatki. Pierwszym z nich jest czarny T-Shirt rozmiaru XL z logo producenta i innymi emblematami przynależności od ekskluzywnego grona użytkowników kart BFG. Wprawdzie nie testowałem koszulki ale nie sądzę, aby posiadacz miał opory przed jej nakładaniem (pomijając kwestię rozmiaru) i zapewnianiem BFG dodatkowej reklamy w miejscach publicznych. Drugim dodatkiem jest zestaw 24-rech samoprzylepnych ślizgaczy poprawiających własności „jezdne” naszych spracowanych gryzoni. Również i w tym przypadku nie czuje się odpowiednim kandydatem do testów tego rozwiązania i mogę jedynie potwierdzić fakt jego dołączenia do wyposażenia karty. Poza tymi elementami reszta zestawu jest typowa. Mamy kompletne okablowanie w postaci dwóch przejściówek DVI->VGA, przejściówki zasilania PCI-E z dwóch molexów oraz panel wyjściowy TV z gniazdami umożliwiającymi przekazywanie sygnałów różnicowych (3x Cinch), S-Video (miniDIN 4pin) oraz zespolonego (Cinch). Do karty dołączono dwie płyty CD. Na jednej znajdziemy sterowniki v83.90 oraz programowy odtwarzacz filmów nvDVD, natomiast na drugiej oprogramowanie narzędziowe (m.in. pełne wersje GameDrive i System Mechanic). Niestety producent nie był tak miły, aby dołączyć do zestawu jakiekolwiek gry.

Sama karta wygląda jak powielenie referencyjnej konstrukcji testowanego wcześniej GF7800GTX. Ten sam zielony laminat, osiem kości Samsung GDDR3 1.1ns na awersie, monstrualne chłodzenie zajmujące dodatkowy slot PCI. W kwestii złączy mamy na śledziu dwa porty DVI, gniazdo zespolone TV-Out, wtyk SLI w górnej części płytki oraz gniazdo zasilania PCI-E w jej tylnej części. Przynależność do BFG oznaczono nadrukami na chłodzeniu, na temat którego miałem już okazję śpiewać hymn pochwalny więc jeszcze raz dodam tylko, że nie widzę sensu jakiejkolwiek jego wymiany, niezależnie od potrzeb w zakresie hałasu. Tym bardziej, że takie praktyki zagrożone są przez producenta utratą dożywotniej gwarancji. Wielki wentylator znakomicie spełnia swoje zadanie, a do tego dysponuje olbrzymim zapasem mocy. Karta chodzi niemal bezszelestnie również po dłuższym wygrzaniu, a rdzeń graficzny osiąga niższą temperaturę niż przy GF7800GTX 512MB.

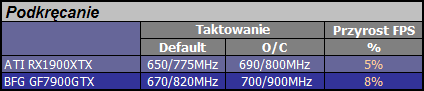

W stosunku do referencyjnego taktowania 650/800MHz karta jest nieznacznie podkręcona. Wartości 670/820MHz nie rzucają na kolana przyrostem i nie należy się po nich spodziewać cudów, ale miłośnicy benchmarków będą w stanie, za pomocą testów potwierdzić fakt większej od standardu mocy.

W czasie testów karta potwierdziła swoje wysokie walory użytkowe, a proponowane przez BFG wyposażenie jest ciekawym urozmaiceniem w stosunku do większości konkurencyjnych produktów. Podstawowe atuty wyróżniające kartę to przede wszystkim jednak wyższe taktowanie i dożywotnia gwarancja. Oczywiście BFG GeForce 7900GTX OC bez najmniejszych wątpliwości zasługuje na uwagę potencjalnych nabywców.

Aktualna cena karty sugerowana przez dystrybutora wynosi 2391 zł.

Warunki testowe

Dzisiejsza recenzja nosi postać pojedynku. Konkurentem dla BFG GF7900GTX będzie Radeon X1900XTX, czyli aktualnie najmocniejsza karta ATI i dotychczasowy lider wydajności.

(kliknij, aby powiększyć)

(kliknij, aby powiększyć)

Przeciwnika wystawiła firma ATI, więc jest to referencyjny model taktowany 650/775MHz. W związku z tym, że oprócz emblematów producenta nie różni się niczym od wcześniej testowanego produktu firmy HIS, to zainteresowani mogą znaleźć szerszy opis w poprzedniej recenzji. Oczywiście zdaję sobie sprawę z faktu, że będę porównywał podkręcony przez producenta model GF7900GTX do znamionowo taktowanego Radeona. W związku z tym, w zestawieniu wyników podam również informację o wpływie różnic w częstotliwościach pracy na średni framerate w trybach testowych.

Jako, że już w styczniowej recenzji kart z najwyższej półki dał się odczuć niedostatek w zakresie dociążenia kart testowych i co za tym idzie pewne ograniczenie wpływu ich mocy na zestawienie końcowe wyników, to sytuacja zmusiła mnie do szeregu zmian zarówno w trybach, jak i samym doborze testów. Niniejszy artykuł wprowadza cały szereg nowych benchmarków, które z uwagi na „świeżość” być może nie są jeszcze ani dostatecznie sprawdzone, ani ostatecznie zakwalifikowane do wykorzystania w kolejnych porównaniach. Co się zmieniło?

Po pierwsze zmieniłem zestaw trybów testowych. Jest to szczególnie ważne w przypadku najmocniejszych kart, bo przy średnim framerate przekraczającym 100 fps można wyciągnąć niewłaściwie wnioski na temat mocy przetwarzania samych układów 3D. Ograniczeniem wyniku może być wtedy zarówno platforma testowa, jak i optymalizacja jej wykorzystania przez same sterowniki. W związku z tym, że głównym zadaniem moich recenzji nie jest określenia zachowania kart w konkretnej grze (czyli de facto nie jest to test gry), ale synteza i porównanie ich wzajemnego potencjału o charakterze jak najbardziej ogólnym. Oczywiście, że to jest całkowicie „wirtualny” parametr, ale praktyka pokazuje, że przy odpowiedniej ilości i ciężarze gatunkowym testów można z całkiem przyzwoitym przybliżeniem określić wzajemne możliwości kart w zakresie uruchamiania aktualnych gier, a nawet tych z bliższej przyszłości. Wobec powyższego, testy przeprowadzane były w trybach 1280x1024, 1280x1024AF, 1600x1200AF i 2048x1536AF. Oznaczenie AF to dodatki do obrazu w postaci FSAA x4 (pełnoekranowy antyaliasing) oraz filtrowania anizotropowego x8. W przypadku gier z efektem HDR (High Dynamic Range) zapisywanym z precyzją FP16 zamiast trybu 1280x1024 występuje 1024x768, a wszystkie mają jedynie dodatek w postaci filtrowania anizotropowego (podobnie jak poprzednik, nowy GeForce nie łączy tego typu HDR z FSAA realizowanym techniką multisamplingu). Podstawą do zestawienia wyników będzie najbardziej obciążający tryb testowy. Rozumiem, że 2048x1536 nijak ma się do realiów życia codziennego gracza, ale tylko w ten sposób mogę w większości przypadków odpowiednio dociążyć najmocniejsze układy graficzne. Pewnym minusem stosowania tak wysokiego trybu jest niebezpieczeństwo zbyt dużego wpływu na framerate przepustowości pamięci w grach z ograniczoną ilością shaderów, ale dopóki nie pojawi się na rynku więcej gier wykorzystujących moc nowych kart to traktuję to jak zło konieczne. W tabelach zainteresowany czytelnik znajdzie średni framerate w trybach zbliżonych do realiów typowych ekranów graczy i jeśli w sam raz trafi na test wykonywany przy pomocy interesującej go gry, to będzie w stanie ocenić w niej zachowanie badanych kart. Nie jest to jednak dla mnie priorytetem.

W stosunku do poprzedniego zestawu testowego obejmującego dziesięć odpowiednio dobranych gier tym razem będzie ich czternaście, co powinno w większym stopniu zbliżyć mnie do wyłonienia zwycięzcy pojedynku. Na zawsze pożegnałem się z wykorzystaniem takich gier jak Tomb Raider AoD, X2 The Threat oraz Colin McRae ’05. Wprowadziłem natomiast Tomb Raider The Legend, X3 Reunion, Call of Duty 2, Need for Speed Most Wanted, Oblivion oraz Serious Sam 2. Zmiany (oprócz trybów) dotknęły również ustawień gier czy demek testowych. W FarCry kwalifikowane do podsumowania testy wykonywane są z efektami HDR, w Half-Life 2 wykorzystuję dodatek The Lost Coast, w LockOn M.A.C. w stosunku do domyślnego ustawienia „High” doszedł większy okrąg renderingu części naziemnej, a w Doom3 przeszedłem z ustawienia jakości High na Ultra. W przypadku nowych benchmarków dodam ewentualny, dodatkowy opis przy tabelkach z wynikami. Przy niektórych testach w nawiasach podaję wartości minimalne framerate. W przypadku gier, które dają niższe wyniki w trybach z FSAA niż z HDR, w zbiorczej klasyfikacji wykorzystuję te pierwsze. Pomiar po drugim przejściu procedury testowej.

Testy wykonywane przy wsparciu platformy opartej na Athlon64 @ 2.4GHz, 1GB DDR, Asrock 939DUAL-SATA2. Sterowniki ATI Catalyst Beta (Oblivion HDR+FSAA patch) oraz 6.4, nVidia v84.21. Ustawienia domyślne oprócz wyłączenia vsync. Wyniki testów prezentowane są w kolejności alfabetycznej.

Testy

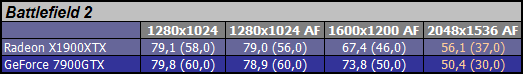

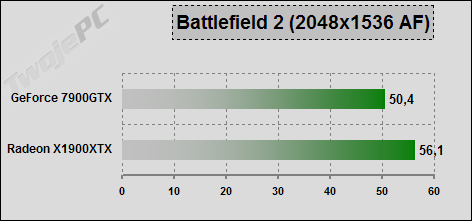

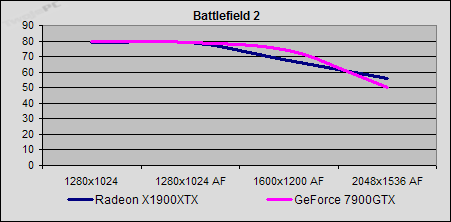

Battlefield 2: Pomiar na demonstracji gry w trybie wbudowanego benchmarka. Wyniki ściągane programem Fraps. Ustawienie filtrowania anizotropowego z poziomu sterowników.

Do 1280x1024AF nie dzieje się nic ciekawego. Karty nie są dociążone. Sterowniki i platforma ograniczają framerate. W 1600x1200AF Radeon zaczyna obniżać „loty” w stopniu większym, niż nowy GeForce, ale na stosunkowo stałym poziomie. W 2048x1536AF GeForce zaczyna wyraźnie słabnąć. Zaliczam zwycięstwo RX1900XTX.

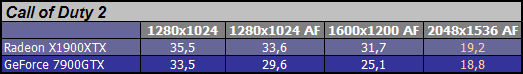

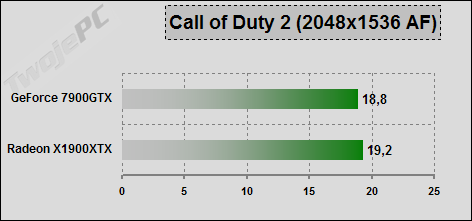

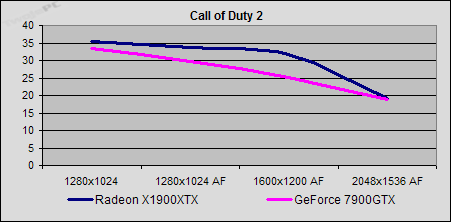

Call of Duty 2: Pomiar za pomocą demka dday_tpu i wbudowanej procedury testowej (timedemo). Ustawienia na maksymalną jakość obrazu.

Sytuacja jakby odwrotna niż w poprzednim teście. GeForce zaczyna wcześniej słabnąć, ale powyżej 1600x1200AF Radeon nagle poddaje się. W najwyższym trybie jest remis, ale jak dla mnie ze wskazaniem na produkt nVidia pomimo wartości framerate.

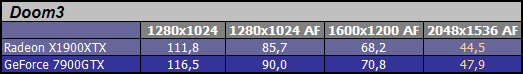

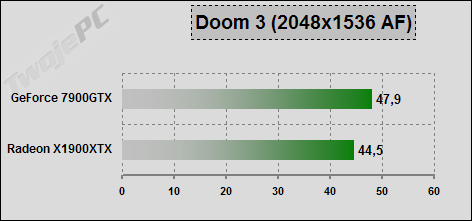

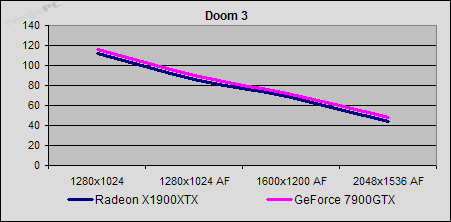

Doom 3: Klasyczny test „timedemo demo1”. Ustawienie jakości „Ultra”. Najwyższy tryb wymaga ręcznej modyfikacji pliku konfiguracyjnego.

Zbliżone zachowanie kart niezależnie od trybu. GeForce ma nad Radeonem niewielką przewagę średniego framerate wynikającą z nieco lepszego dostosowania sterownika. Na punkty zwycięża GF7900GTX, choć realnie powinno się pisać o remisie.

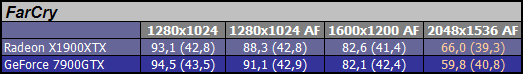

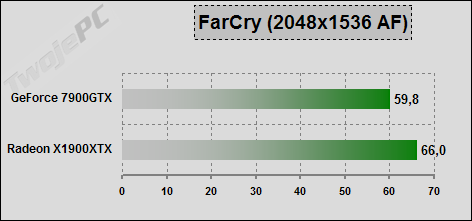

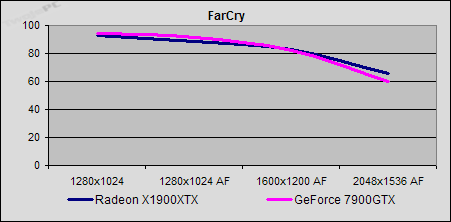

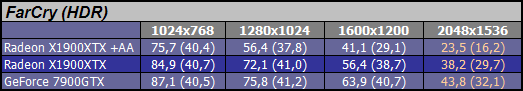

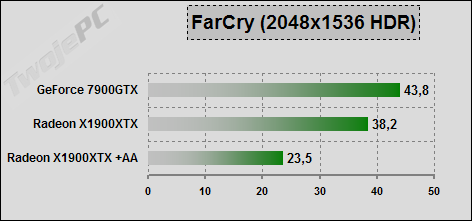

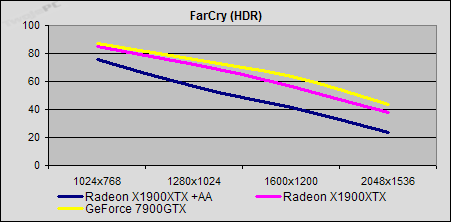

FarCry: Skoro w poprzednich ustawieniach nie udało mi się „zajeździć” najmocniejszych kart, to postanowiłem dorzucić im kłodę w postaci HDR. Patch beta 1.4. Ustawienie HDR na wartość „7”. Poprzez ustawienie FSAA na wartość „2” można włączyć na kartach Radeon efekt FSAA (już oczywiście poza konkurencją). Wewnętrzna procedura testowa nie odzwierciedla realnego framerate. Wyniki można przyjmować jedynie porównawczo.

W odróżnieniu od wcześniejszych testów (starsze sterowniki), gdzie po pewnym czasie „różowy budyń” zalewał mi ekran GeForce’a tym razem w końcu mogłem pograć z HDR w bardzo „kulturalny”, choć niewątpliwie kosztowny (ceny kart) sposób. Różnice pomiędzy kartami niewielkie, ale zwycięstwo GF7900GTX nie budzi wątpliwości. Dla mnie jednak moralnie wygrał Radeon z uwagi na możliwość znaczącego polepszenia obrazu filtrowaniem „schodków”. Oczywiście kosztem zmniejszenia rozdzielczości. Do klasyfikacji zbiorczej użyję wyników z HDR.

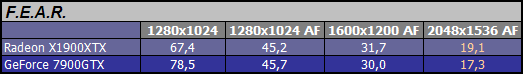

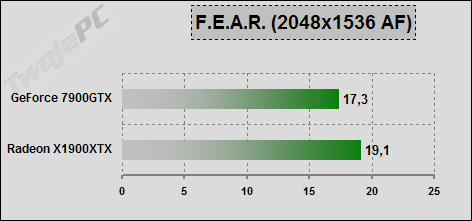

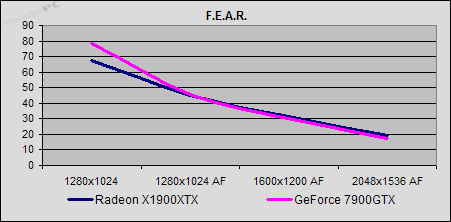

F.E.A.R.: Tu w zasadzie nic nie zmieniłem. W obliczu potężnej dawki shaderów nawet najmocniejsze karty dostają czkawki w wyższych trybach. Pomiar za pomocą Fraps na początkowym odcinku demonstracyjnej wersji gry.

Obie karty bardzo nerwowo reagują na włączenie FSAA. Szczególnie GeForce. W przypadku tego ostatniego widać bardzo duży postęp w stosunku do możliwości poprzednika. Teraz mamy już niemal remis choć oczywiście odnotowuję minimalne zwycięstwo Radeona.

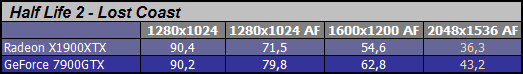

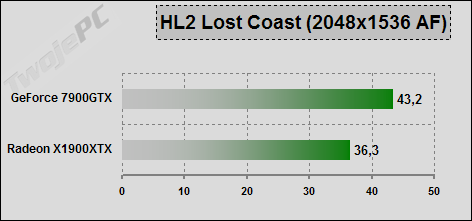

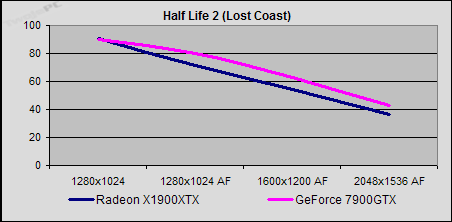

Half-Life 2 – Lost Coast: Test za pomocą nagranego demka z przejścia całego poziomu i wewnętrznych procedur gry (timedemo). Metoda implementacji efektu HDR umożliwia łączenie go z FSAA również w wypadku kart GeForce.

Całkiem bezpieczne zwycięstwo GeForce 7900GTX. Brawo. Czy ktoś jeszcze pragnie twierdzić, że to gra ATI?

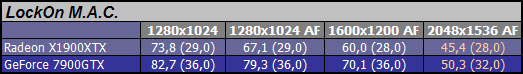

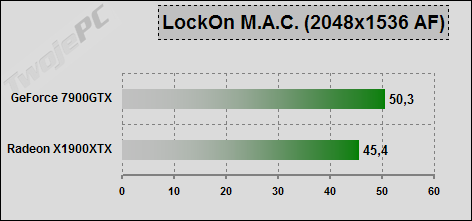

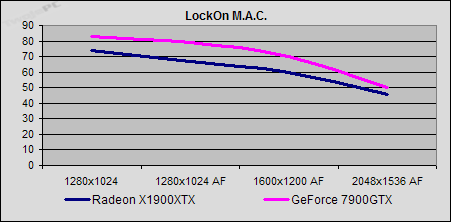

LockOn – Modern Air Combat: Pomiar za pomocą Fraps w czasie lotu F-15 na małej wysokości.

Dzięki zwiększeniu ilości obiektów naziemnych i wprowadzeniu wyższej rozdzielczości udało się w końcu dociążyć karty. Wciąż jednak GF7900GTX ma pewną przewagę nad rywalem.

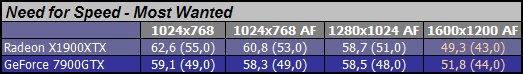

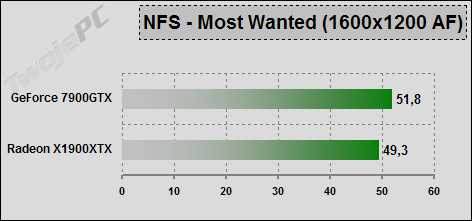

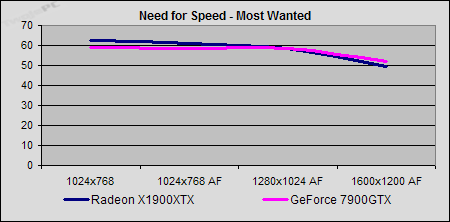

Need for Speed – Most Wanted: Pomiar za pomocą Fraps odcinka przejazdu gry w wersji demonstracyjnej. Nie udało mi się uruchomić trybu wyższego niż 1600x1200 AF więc dla zachowania spójności wprowadziłem niższy tryb.

Framerate praktycznie niemal cały czas „leży” na procesorze. Drobne różnice dopiero w najwyższym trybie. W zasadzie remis, choć na punkty minimalne zwycięstwo notuje GeForce. Niestety ta gra nie nadaje się do testów i pewnie w przyszłych recenzjach jej nie będzie. Muszę spróbować z inną nową „samochodówką”.

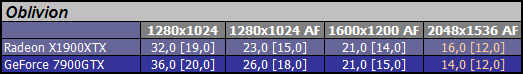

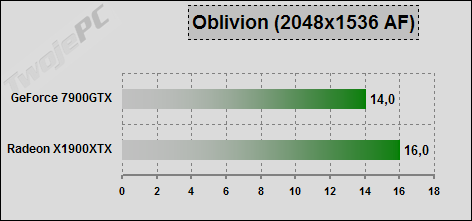

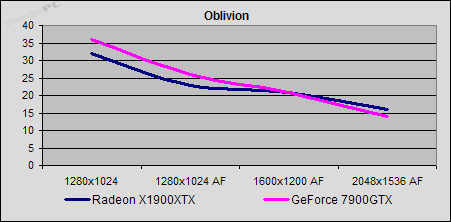

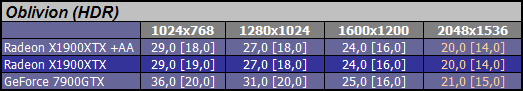

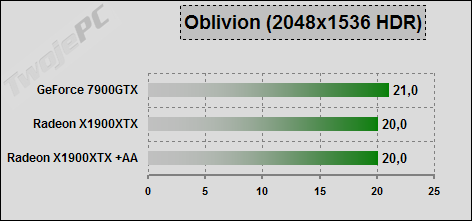

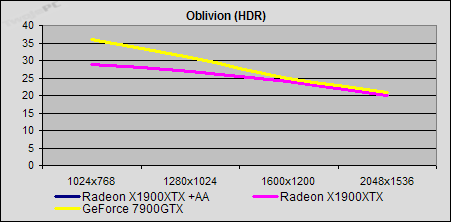

Oblivion: Bardzo mi zależało na testach w tej grze, ale muszę przyznać, że to co wykombinowałem, aby uzyskać powtarzalność wyników mnie samemu się niezbyt podoba. Gra losowo generuje ruchome fragmenty sceny, a do tego ma dużą zmienność framerate w zależności od rodzaju przetwarzanego obiektu. Po dłuższej walce udało mi się znaleźć maleńki fragment przejścia bohaterem na otwartym terenie, który daje na Fraps powtarzalny średni framerate. Dodatkowo, aby nie było wątpliwości co do różnic daję w nawiasach kwadratowych wynik statyczny po wgraniu save’a.

W notowanych dla potrzeb zbiorczego porównania wyników z FSAA wraz z trybem Radeon goni przeciwnika i w najwyższym osiąga nad nim przewagę. Framerate koszmarnie niski, a wyniki nieco dziwaczne choć faktycznie tak się zachowywała gra. Przy HDR trudno mi nawet je interpretować. Dorzucenie w sterowniku filtrowania w przypadku RX1900XTX nijak nie wpływa na niego, choć obraz faktycznie się polepsza. W zasadzie to właśnie powinno przesądzić o zwycięstwie karty ATI, ale w obliczu 20 fps nie ma się czym entuzjazmować. Więcej testów Obliviona nie będzie. No chyba, że ktoś przygotuje i zaszyje w grze odpowiednie procedury testowe.

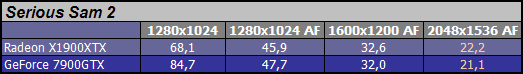

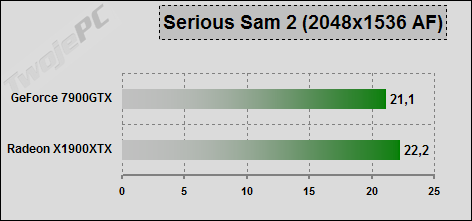

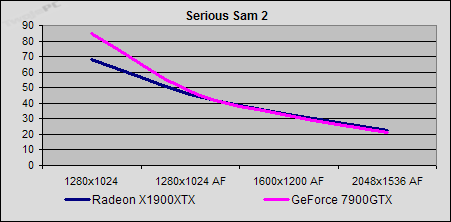

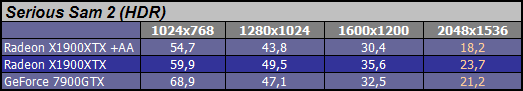

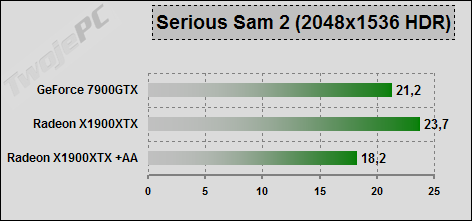

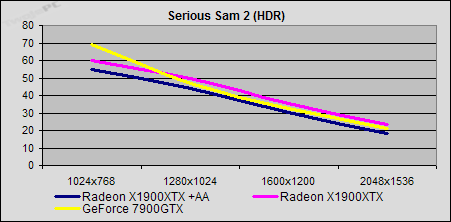

Serious Sam 2: Gra w wersji demonstracyjnej. Pomiar za pomocą wbudowanego benchmarka własnoręcznie nagranego fragmentu walki na otwartej przestrzeni.

Nieco niższe wyniki występują w trybach z FSAA zamiast HDR więc to one będą brały udział w konkursie. Tym bardziej, że sam HDR specjalnie się nie rzuca się w oczy na otwartych przestrzeniach. FSAA kosztuje karty sporą moc. Szczególnie produkt nVidia. Wraz z trybem Radeon zmniejsza przewagę nad kartą GeForce i w najwyższym w końcu ją dopada. Oczywiście to tylko zabawa w liczby bo realnie odnotowuję remis. Dla trybów HDR lepszą propozycją jest karta ATI, z uwagi na połączenie tego efektu z filtrowaniem „schodków”.

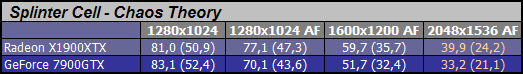

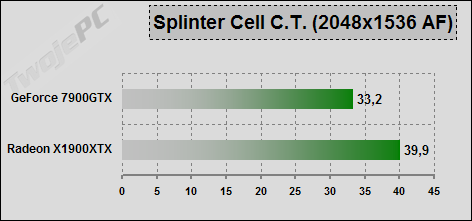

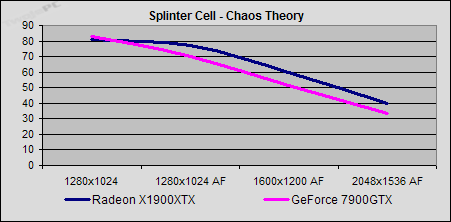

Splinter Cell – Chaos Theory: Warunki testowe jak w poprzednich recenzjach. Wbudowany benchmark. Włączone wszystkie efekty.

Powyżej 1280x1024AF następuje dociążenie kart. Z pojedynku zwycięsko wyszedł Radeon, choć dopiero w najwyższym trybie da się odczuć różnicę w czasie gry.

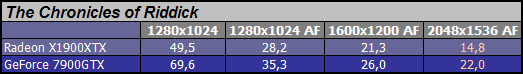

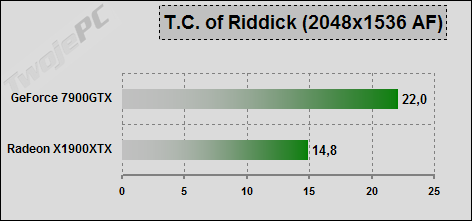

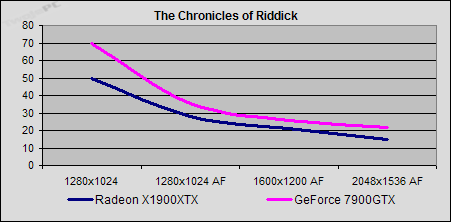

The Chronicles of Riddick: Dedykowany programik testowy z własnym demkiem. Nieprzypadkowo wybrany, bardzo obciążający fragment gry.

W obliczu efektów wykorzystujących UltraShadow via OpenGL karta ATI nie ma żadnych szans. Spektakularne zwycięstwo GF7900GTX. Ten test pewnie najmocniej zaważy na ogólnej punktacji.

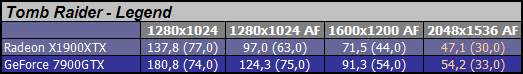

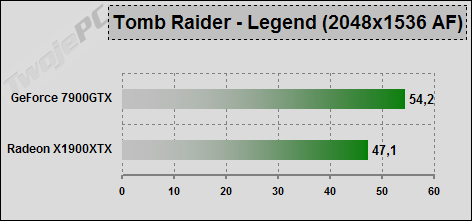

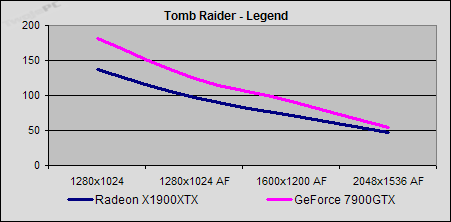

Tomb Raider – The Legend: Wersja demonstracyjna najnowszych przygód Lary Croft. Pomiar za pomocą Fraps na początkowym „filmiku” wprowadzającym.

Wraz ze wzrostem trybu przewaga GF7900GTX maleje, ale nie pozostawia wątpliwości co do zwycięzcy.

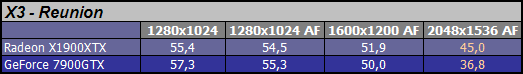

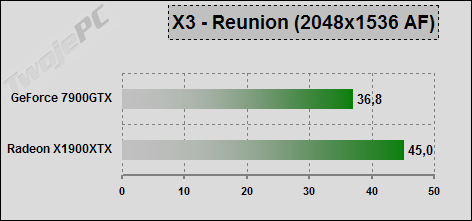

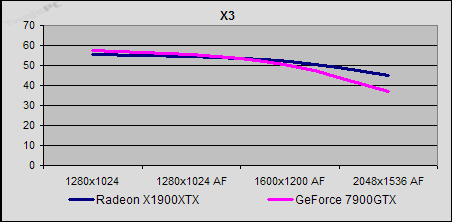

X3 – Reunion: Dedykowany benchmark oparty na silniku gry.

Stosunkowo stabilny framerate i spory zapas mocy. Wraz z wzrostem trybu GeForce słabnie wyraźnie szybciej. Tym razem punkt dla RX1900XTX.

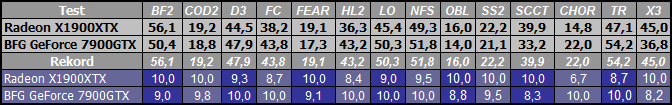

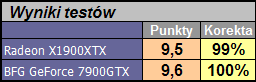

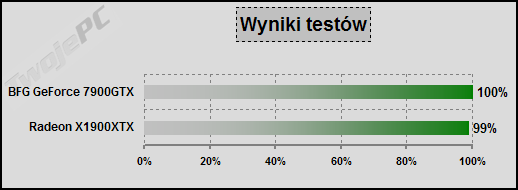

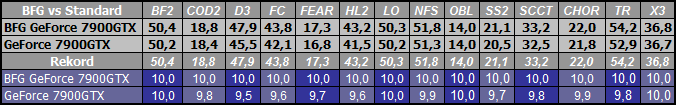

Zestawienie wyników

Przyszedł czas na zsyntezowanie zestawu wyników. Wybrałem po jednym, najbardziej obciążającym karty trybie, z każdej z czternastu gier testowych. Zwycięzca danej konkurencji otrzymuje 10 punktów natomiast przegrany proporcjonalnie (licząc od zera) mniej. Średnia z wszystkich konkurencji po przeliczeniu na skalę procentową (100% dla zwycięzcy) daje końcowy wynik kart.

Chyba zaczynam rozumieć skąd te rozbieżności w typowaniu najsilniejszej karty na rynku, w zależności od recenzji. Średnio licząc karty zbierają niemal tą samą ilość punktów. Jednym procentem „wygrał” BFG GF7900GTX.

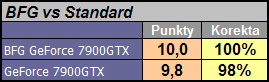

W związku z tym, że testowana karta miała podwyższone, w stosunku do referencyjnych, taktowania rdzenia i pamięci to warto sprawdzić, jaki to miało wpływ na wynik.

W związku z tym, że różnica w częstotliwościach pracy jest niewielka to i wyniki są bardzo zbliżone. Oczywiście te 2% pozwoli karcie BFG wygrać porównanie z domyślnie taktowanym GF7900GTX, ale kwestia dotyczy jedynie dokładnych testów, bo w realnej grze nie jesteśmy w stanie tego wyczuć. Okazało się, że właśnie ta niewielka różnica miała wpływ na zwycięzcę podstawowego zestawienia wyników.

Oczywiście to tylko zabawy liczbami. Przy tak niewielkich średnich różnicach nie ma mowy, aby którąkolwiek z kart ocenić jako mocniejszą od drugiej. Konkurenci prezentują zbliżony poziom mocy. W konkretnej grze czy ustawieniach możemy się spotkać z różnicami framerate, które dadzą się bez problemu „wyczuć”, ale przy większym zbiorze gier znajdą się zarówno takie, które będą preferowały karty ATI, jak i takie, w których nVidia będzie na czele. Wszystko wskazuje na to, że po uśrednieniu, uzyskujemy remis w konkurencji wydajności. Bywa i tak ...

Dodatkowe testy

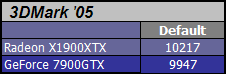

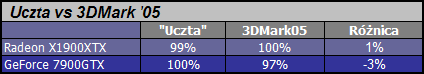

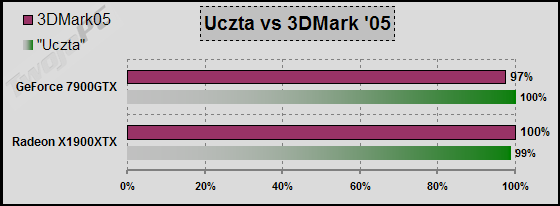

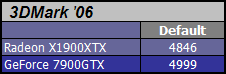

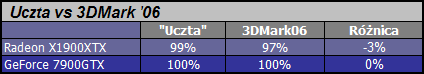

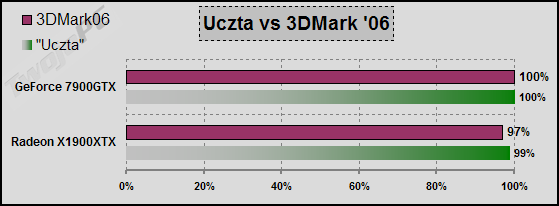

W dzisiejszej recenzji dodatkowe testy ograniczają się do porównania wyników „uczty numerologa” z 3dmarkami oraz określenia podatności badanych kart na nadtaktowanie.

Jeśli ktoś wierzył, że pojedynek tych gigantów są w stanie rozstrzygnąć syntetyczne testy FutureMark’a, to się rozczaruje. Również i tu mamy różnice, które nie przekraczają 3%.

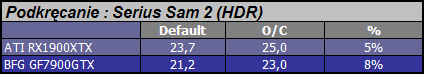

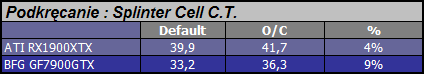

Ostatni przewidziany w tej recenzji zestaw wyników jest związany z kwestią podkręcania. Do testów wpływu zwiększenia częstotliwości zegarów taktujących rdzeń i pamięci wybrałem Serious Sam 2 (HDR) oraz Splinter Cell – Chaos Theory.

Kwestia podkręcania jest oczywiście związana z konkretnym egzemplarzem karty aczkolwiek często wartości osiągane przez inne karty są podobne. Jeśli traktować ten proceder jako dodatkową konkurencję to wygrał ją BFG GF7900GTX. Przewagę nad referencyjną kartą ATI zawdzięcza większym zapasem możliwości pamięci. Niestety nadal jednak są to różnice, które nie przekraczają 5%. Nie uda nam się ich wychwycić bez dokładnych testów.

Podsumowanie

Jeśli ktoś szczęśliwie przebrnął przez tą kakofonię liczb to w zasadzie mógłby stwierdzić, że za ich pomocą udało mi się jedynie ubić trochę recenzyjnej piany. Jeśli szukał w artykule dowodów na niezaprzeczalną „lepszość” którejś z tych dwóch wspaniałych kart, to mam wrażenie, że się rozczarował. Aby nie było najmniejszej wątpliwości co do mojego spojrzenia na wydajność tych gigantów, to mogę jedynie potwierdzić to, co przynajmniej dla mnie, jasno wyrażają wyniki testów. Oba produkty mają zbliżoną moc przetwarzania grafiki. W zależności od konkretnego silnika gry, aktualnego dostosowania sterownika czy ustawień, każda z opisywanych kart może uzyskać niewielką przewagę nad konkurentem, ale już w następnej próbie ulec przeciwnikowi. Zrozpaczony takim obrotem sprawy, bezbronny choć zamożny klient ma jednak prawo spytać, którą z kart wybrać do karmienia gier, na swoim wspaniałym pececie. W wyborze można się oczywiście kierować nawet jedną, konkretną, ulubioną grą, ale z uwagi na niewielkie różnice (nawet w ekstremalnych trybach) raczej nie powinno to stanowić o wyborze. Skoro nie wydajność, to jakim kierować się kryterium? Oczywiście karty nie są jednorodne w kwestii walorów użytkowych i funkcjonalności. Sądzę, że warto przypomnieć parę pozawydajnościowych faktów z życia bohaterów tej recenzji.

Pierwszym i chyba najistotniejszym elementem, wpływającym na możliwość rozwiązania tej łamigłówki może być prosta zasada przywiązania do konkretnego producenta. Mam wspaniałą wiadomość dla miłośników kart nVidia. Dzięki pojawieniu się nowej, wydajniejszej karty GeForce nie musicie już rozważać kupna Radeona. Mam równie wspaniałą wiadomość dla fanów produktów spod znaku ATI. Pomimo premiery nowszej i wydajniejszej karty GeForce Radeon pozostaje dobrą opcją zakupową. Po prostu nadal nie trzeba zmieniać dotychczasowych preferencji. Co natomiast jeśli ich nie mamy?

GeForce 7900GTX przede wszystkim kusi walorami użytkowymi. Bardzo ciche chłodzenie bez konieczności wymiany nawet w przypadku użytkowników o wrażliwym słuchu, znaczniej mniejszy pobór mocy umożliwiający zachowanie dotychczasowego zasilacza, nawet jeśli nie ma on specjalnie wyśrubowanych parametrów. Gdy producent osiągnie odpowiednią dla popytu wartość produkcji to jeśli karty konkurencji nadal będą się dobrze sprzedawały, może dorzucić lizaka w postaci obniżenia ceny. Przy tej wielkości rdzenia (ponad 100 mln tranzystorów mniej od R580) ma na każdym układzie większy od ATI zysk, którym może się podzielić z klientem. Inna sprawa, że w przypadku produktów z najwyższej półki cenowej różnica nawet paruset zł niekoniecznie jest w stanie wywrzeć na zamożnym kliencie odpowiedni nacisk. Inne zalety to prostota migracji do układu dwóch kart i systemu SLI. Dwugniazdowe płyty oparte na chipsecie nForce4 są dostępne na rynku od dłuższego czasu i dzięki dobrej opinii są bazą wielu mocnych pecetów opartych na dobrze sprawdzających się w grach procesorach Athlon64. Do tego mamy stosunkowo dobre oprogramowanie takiego tandemu w sterownikach i brak konieczności zakupu specjalnej karty nadrzędnej, jak w przypadku ATI. Z innych zalet wymienić należy lepszą optymalizację wykorzystania procesora co przekłada się na wyższy średni framerate w niższych trybach. Nie ma to jednak większego wpływu na odczuwalną płynność generowanej sceny, bo dzieje się tak głównie w obliczu słabego dociążenia samego układu graficznego. No i na koniec istotna kwestia dopasowania do nieco starszych gier. Z jednej strony mamy rozbudowany program współpracy z programistami gier, który w konkretnych przypadkach zaowocował lepszym dostosowaniem do architektury układów nVidia (np. Riddick), a z drugiej potężną moc związaną z możliwościami jednostek teksturowania. Przy oparciu efektów na filtrowaniu dużych tekstów w wyższych trybach GeForce powinien lepiej się dostosować.

Czym natomiast przyciągnąć nas może Radeon X1900XTX? W chwili obecnej bezsprzecznym magnesem jest oczywiście kwestia łączenia wydajnej techniki wygładzania „schodków” (multisampling FSAA) z dowolną realizacją efektu HDR. Wprawdzie gier wykorzystujących HDR nie ma dużo, a rendering konsumuje bardzo dużą część mocy układu, ale dla najbardziej bezkompromisowych użytkowników może mieć znaczenie fakt braku jakiegokolwiek technicznego ograniczenia w jakości obrazu. Kolejną zaletą Radeona, która choć nie związana z grami, może być dla kogoś istotna to sprawy związane z przetwarzaniem i wyświetlaniem filmów przy wsparciu peceta. Rozbudowana funkcjonalność sterownika połączona z aktualnie najbardziej zaawansowanym hardware w zakresie przetwarzania strumienia obrazu, a do tego dostępny bez dodatkowych opłat enkoder, niewątpliwie mogą kusić przynajmniej część potencjalnych nabywców. Większość pozostałych zalet RX1900XTX wiąże się bardziej z wizją przyszłości przetwarzania gier niż tym, co aktualnie możemy wykorzystać. Gigantyczna moc przetwarzania shaderów wymaga pożywienia, którego dzisiejsze gry nie są w stanie karcie dostarczyć. Wprawdzie wszystko wskazuje na to, że kierunek rozwoju architektury przyjęty przez ATI został zaakceptowany zarówno w postaci opracowywanych standardów nowego API, jak i samych programistów gier, ale realny czas wprowadzenia ich w życie nie został jeszcze określony. Zresztą sam proces zmian kierunku metod realizacji efektów zawsze jest rozciągnięty w czasie i w zasadzie już się rozpoczął.

Mam nadzieję, że powyższy opis jest w stanie pomóc w wyborze odpowiedniej karty. Jeśli ktoś nadal ma wątpliwości i czeka na konkretniejsze wskazówki to mogę jeszcze dodać bardziej subiektywną wskazówkę. Z listów, które dostaje wynika, że świadomych i faktycznie zainteresowanych zakupem najdroższych kart na rynku miłośników gier mogę podzielić na dwie grupy. Pierwsza wymienia część peceta niemal co pół roku wykorzystując aktualną ofertę producentów tak, aby cały czas zachować dominację sprzętową natomiast druga wymienia niemal cały sprzęt co parę lat, a decyduje się na topowe rozwiązania po to, aby czas pozostający do wymuszonego przez oprogramowanie upgrade był jak najdłuższy. Pierwszej grupie zaproponowałbym zakup GeForce 7900GTX natomiast drugiej Radeona X1900XTX. Mam nadzieję, że motyw takiego doboru jest zrozumiały po lekturze poprzednich akapitów.

Sprzęt do testów dostarczyły firmy: Sprzęt do testów dostarczyły firmy:

|

|  | eXtremeMem |

|