|

TwojePC.pl © 2001 - 2025

|

|

RECENZJE | GeForce 7800 GTX: recenzja i test |

|

| |

|

GeForce 7800 GTX: recenzja i test

Autor: Kris | Data: 06/07/05

|

Pomimo przejściowych problemów z wygospodarowywaniem czasu, niezbędnego do pisania recenzji, pojawienie się nowego lidera wydajności wśród kart graficznych nie mogło pozostawić mnie obojętnym. Dzięki uprzejmości firmy nVidia, która udostępniła mi referencyjną kartę GeForce 7800 GTX oraz firm Gigabyte, MSI, Gainward, AMD i Sapphire, które umożliwiły mi skompletowanie platformy sprzętowej i zestawu do porównań wydajności, mam niewątpliwą przyjemność podzielenia się z Czytelnikami wynikami testów oraz wnioskami płynącymi z kilkudniowego obcowania z najnowszym produktem nVidia. Zapraszam do stosunkowo krótkiej, choć mam nadzieję, że treściwej recenzji. Pomimo przejściowych problemów z wygospodarowywaniem czasu, niezbędnego do pisania recenzji, pojawienie się nowego lidera wydajności wśród kart graficznych nie mogło pozostawić mnie obojętnym. Dzięki uprzejmości firmy nVidia, która udostępniła mi referencyjną kartę GeForce 7800 GTX oraz firm Gigabyte, MSI, Gainward, AMD i Sapphire, które umożliwiły mi skompletowanie platformy sprzętowej i zestawu do porównań wydajności, mam niewątpliwą przyjemność podzielenia się z Czytelnikami wynikami testów oraz wnioskami płynącymi z kilkudniowego obcowania z najnowszym produktem nVidia. Zapraszam do stosunkowo krótkiej, choć mam nadzieję, że treściwej recenzji.

| |

|

Teoria

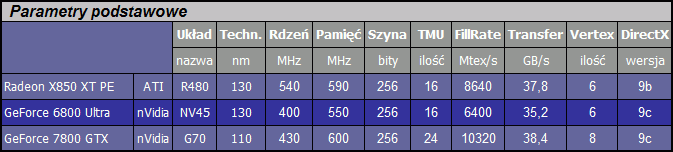

GeForce 7800 GTX jest pierwszą kartą opartą na układzie G70, którego premiera miała miejsce 22 czerwca 2005. Jego architektura wywodzi się wprost z linii NV4x, choć dokonano kilku istotnych zmian, na które chciałbym zwrócić szczególną uwagę.

Układ G70 składa się z rekordowej ilości 302 mln tranzystorów. Dla porównania, rdzeń GeForce 6800Ultra miał 222 mln, a Radeon X850XT PE 160 mln. Dzięki przejściu na technologię krzemową 0.11um udało się utrzymać zarówno stosunkowo wysokie taktowanie 430MHz, jak i zachować ten sam poziom wydzielanej przez układ mocy.

Zdecydowanie najważniejszą zmianą, w stosunku do poprzednika, jest dodanie do potoków pikseli ośmiu jednostek cieniowania. Mamy więc pierwszego na świecie 24-potokowca (poprzednia generacja miała do 16 potoków). W przypadku nowych układów pojęcie potoków jest raczej umowne, ponieważ nie zmieniono ilości modułów ROP (Raster Operation), odpowiedzialnych za końcową część procesu cieniowania. Układ faktycznie jest w stanie wykonywać 24 jednoczesne operacje, ale w jednym cyklu zegara zapisuje do pamięci "jedynie" 16 gotowych pikseli. Podobnie, jak i jego poprzednik. Dzięki temu udało się ograniczyć wielkość rdzenia przy niewielkiej, realnej utracie mocy przetwarzania. Ten sam trik sprawdził się w przypadku kart serii 6600, a idea bazuje na optymalizacji zależności czasowych pomiędzy poszczególnymi etapami procesu cieniowania pikseli.

Oprócz zmian ilościowych w potokach mamy też do czynienia z usprawnieniem działania samych shaderów. Do bloku przetwarzania dodano tzw. Mini-ALU (pomocnicze jednostki arytmetyczno-logiczne) odpowiedzialne za przyspieszenie konkretnych operacji matematycznych. Jak już wspominałem w starszych artykułach, metoda przetwarzania układów nVidia opiera się na większej ilości specjalizowanych instrukcji, wymagających większej ilości cykli zegara. Opracowując nową mutację układu, można w wyniku analizy zachowania shaderów odnaleźć wąskie "gardła" procesu i dokonać korekty poprzez dodanie niewielkiej, dedykowanej jednostki pozwalającej rozładować konkretne spiętrzenia danych, oczekujących na przetworzenie. Podobne "implanty" zastosowano z powodzeniem np. przy unowocześnianiu NV30 i również mamy z nimi do czynienia w G70.

Wraz z nowym układem dostajemy również znacznie lepszy moduł PureVideo. Jest to specjalizowana jednostka, odpowiedzialna za zdjęcie z procesora obciążenia, związanego z przetwarzaniem strumienia obrazu (filtrowanie, akceleracja kodowania/dekodowania, usuwanie przeplotu, korekcja koloru itd.). Pierwsza wersja PureVideo pojawiła się wraz z GeForce 6800 Ultra i ... nie działała. W kolejnych mutacjach rdzenia poprawiono błąd, a w serii 6600 wprowadzono kilka ulepszeń. Wraz z G70 dostajemy drugą generację PureVideo m.in. ze wsparciem sprzętowym dla HD WMV, którego zabrakło w poprzedniej wersji i wieloma innymi udogodnieniami, którymi nie dysponuje aktualnie konkurencja (no może oprócz najnowszych układów S3 serii GammaChrome).

Bezpośredni wpływ na wydajność 3D ma również dodanie dwóch jednostek Vertex Shader. G70 ma ich łącznie 8. Nic konkretnego nie można jednak napisać o ich zmianach jakościowych. Nadal brak jest filtrowania i nie można spodziewać się zmiany generacji w tej części obsługi efektów SM3.0, choć nVidia chwali się pewnym poprawieniem działania HDR (High Dynamic Range). Tu jednak mam dosyć sceptyczne podejście, bo nawet jeśli udało im się uzyskać 50% wzrost wydajności, to nie widzę szansy na to, że pojedyncza karta da sobie radę z tym efektem powyżej 1024x768 przy sensownym framerate.

Operacja tworzenia przez nVidia układu G70 przypomina proces przejścia ATI od R9800Pro do X800XT. Charakter zmian głównie zmierza w kierunku poprawienia wydajności przy minimalnych zmianach w architekturze pojedynczych potoków. Efekt osiągnięto dzięki zmianie technologii wytwarzania, co umożliwiło upchnięcie dodatkowych potoków, a całość uzupełnia kilka miłych dodatków i "tuning" samych jednostek obliczeniowych. W związku z tym, że konkurencja ma mniejsze możliwości w zakresie przetwarzania efektów 3D, to strategia nVidia wydaje się całkowicie uzasadniona. Do przewagi technologicznej dorzucono znaczące przebicie wydajnością i teraz piłka powędrowała do ATI. Kanadyjczycy mają znacznie więcej do zrobienia więc nVidia może spokojnie czekać na ich ruch.

|

|

|

|

|

|

|

|

|

|